- AI Dev - 인공지능 개발자 모임

- 정보공유

- 챗봇 딥러닝

게리 마커스는 뉴욕대 심리학과 교수로 그동안 딥러닝의 한계를 지적해왔습니다. 신경망이 인과관계를 파악하기 위해서는 과거와 같은 기호적인 방법을 도입해야 한다고 주장합니다. 반면에 힌튼, 벤지오, 르쿤은 딥러닝 안에서 인과적인 처리가 필요하다며 설전을 벌이기도 했습니다.

"What happens when you stack kindling and logs in a fireplace and then drop some matches is that you typically start a -> ick?"

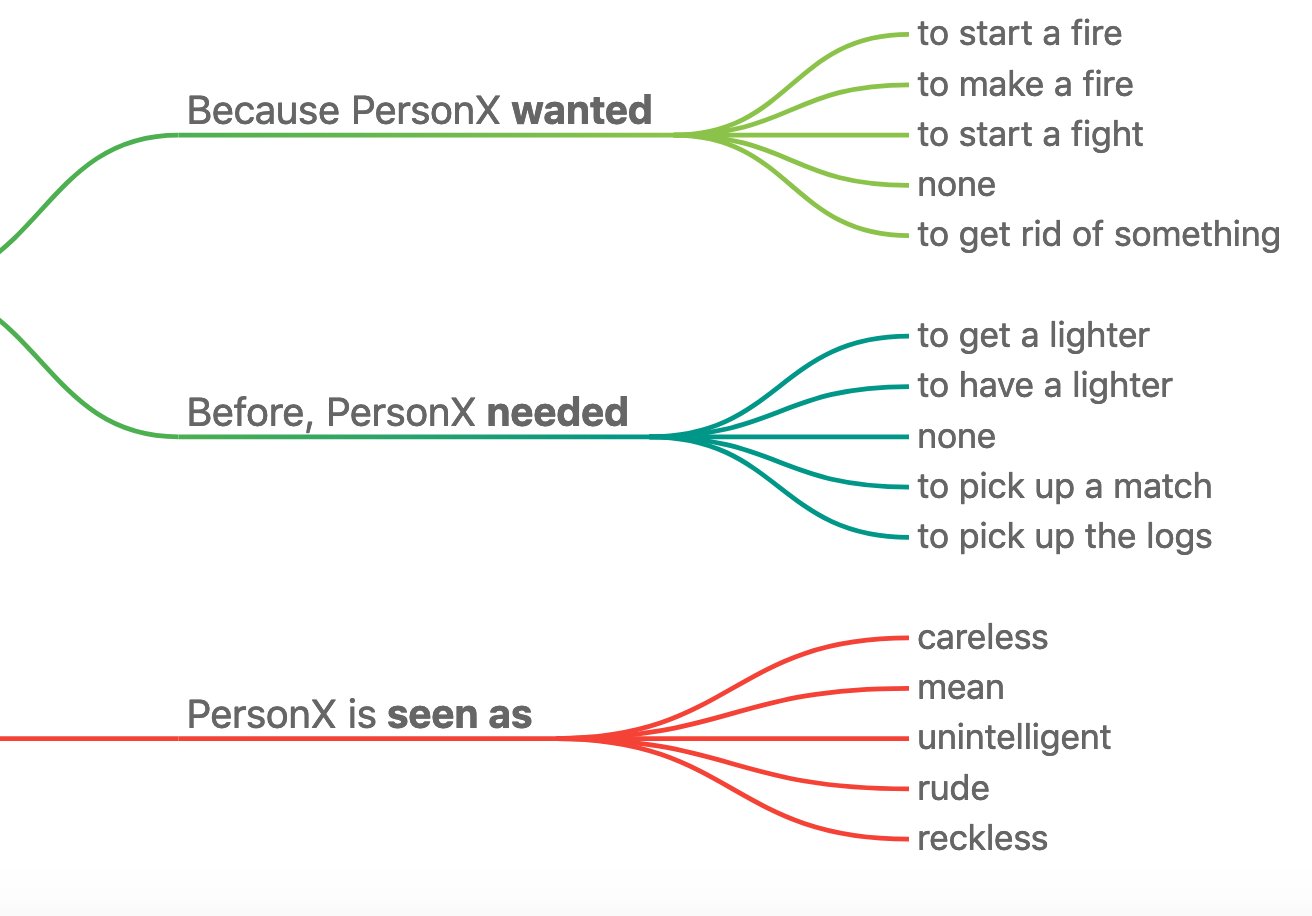

작년 말에는 위과 같은 트윗을 남기며 또 다시 딥러닝을 비판했습니다. 사람은 정답인 fire를 쉽게 알 수 있습니다. 하지만 GPT2는 ick라는 잘못된 단어를 출력합니다. 여기에 워싱턴대 최예진 교수님이 반박하는 답글을 달았습니다. 현재 개발중인 딥러닝 상식추론 모델 COMET은 'to start a fire' 처럼 근접한 대답이 나옵니다.

COMET의 구현과정은 다음과 같습니다. 먼저 크라우드소싱으로 예문에 대한 원인과 결과 문장을 사람이 작성합니다. 그다음 트랜스포머에 (질문, 관계)를 넣으면 (대답)이 나오도록 학습니다.

(영화를 보고 싶다, 원인) -> (재미를 얻기 위해)

(영화를 보고 싶다, 결과) -> (극장에 간다)

딥러닝도 방법을 달리 하면 인과관계를 처리할 수 있음을 보여주고 있습니다. 아직은 기초적인 수준이지만 앞으로 계속 발전하길 기대해봅니다.

< COMET 테스트 >

-> https://mosaickg.apps.allenai.org/comet_atomic

< 관련 기사 >

-> https://www.quantamagazine.org/common-sense-comes-to-computers-20200430/