- AI Dev - 인공지능 개발자 모임

- 정보공유

- 일반 인공지능

글 수 118

http://www.newspim.com/news/view/20190911001200

신경망의 손실함수(loss function)은 보통 분류와 회귀가 서로 다릅니다. 분류는 크로스엔트로피(cross entropy), 회귀는 평균제곱오차(mean square error)를 사용합니다. 물론 분류에도 MSE를 적용할 수 있지만, CE를 쓰는게 더 학습이 빠릅니다.

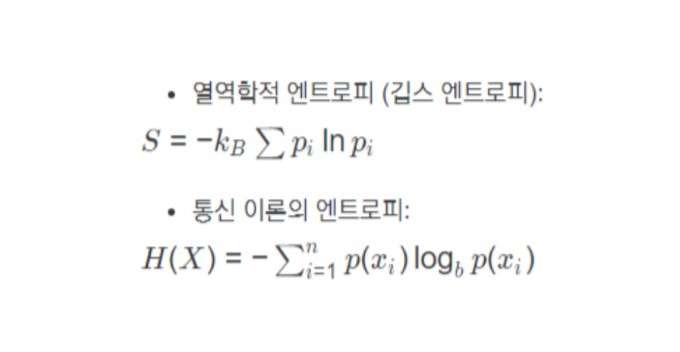

여기서 엔트로피라는 용어가 무엇을 의미하는지 궁금하신 분들이 많을 텐데요. 여기에 대해 잘 정리한 글입니다. 간단하게 말하면 엔트로피는 열역학 제2법칙인 무질서도를 뜻합니다. 예를 들어, 10명의 사람들 중 모두가 180cm라면 엔트로피가 낮습니다. 반대로 10명의 키가 각각 다르다면 엔트로피가 높다고 볼 수 있습니다. 이를 손실함수에 적용하면 오차가 얼마인지 계산이 가능합니다. 예측값과 정답 사이의 엔트로피가 작게 되도록 학습을 하는게 목표입니다.