- AI Dev - 인공지능 개발자 모임

- 정보공유

- 챗봇 딥러닝

글 수 295

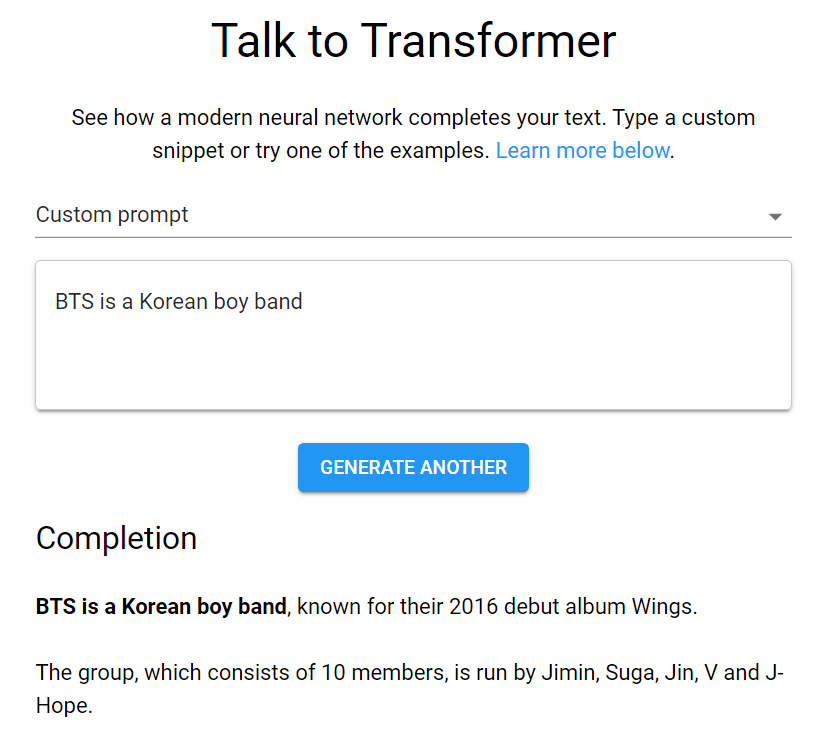

https://talktotransformer.com/

GPT2를 테스트해볼 수 있는 사이트입니다. 나온지는 오래되었는데요. 지금은 가장 큰 사이즈인 1.5B 모델로 동작합니다. 문장을 입력하고 버튼을 누르면 이어지는 텍스트를 생성합니다.

BTS에 대한 글을 만들어보았는데 그럴듯한 내용이 나왔습니다. 다만 구체적인 사실은 실제와 조금씩 달랐습니다. 아마 관련된 데이터가 적어서 그런 것 같습니다. 또한 문장의 구조는 맞지만 의미가 틀리는 경우가 많이 발생하기도 합니다. GPT2의 한계라고 생각합니다.