- AI Dev - 인공지능 개발자 모임

- 정보공유

- 챗봇 딥러닝

글 수 283

https://huffon.github.io/2019/11/16/glue/

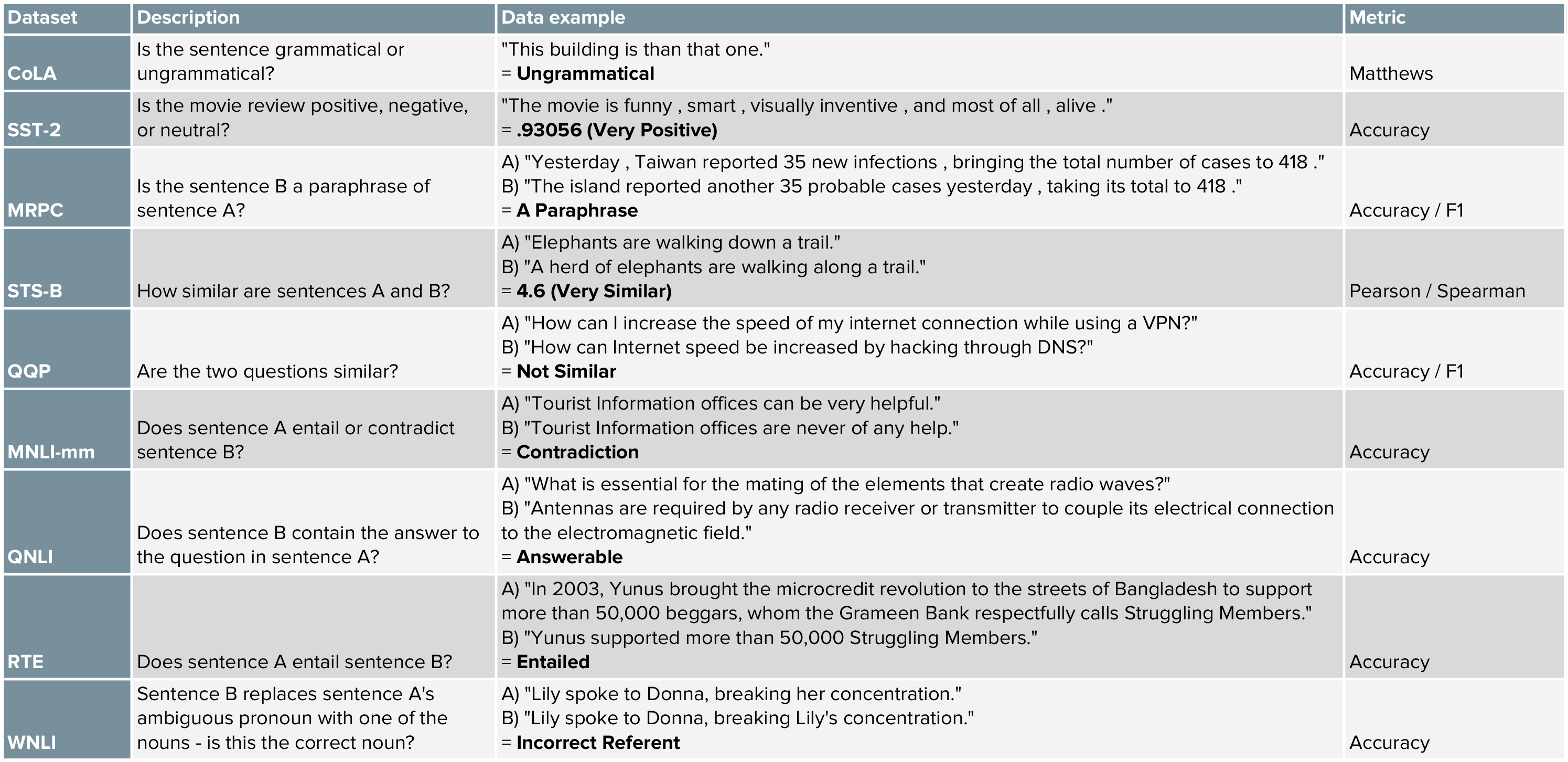

GLUE(General Language Understanding Evaluation)에 대해 매우 쉽게 설명한 글입니다. GLUE는 이름 그대로 범용적인 자연어처리 모델을 평가하는 방법입니다. 하나가 아니라 여러가지 태스크들을 수행하고, 그 값을 취합하여 최종 점수를 얻습니다. BERT 같은 사전훈련 모델의 성능을 측정하는데 많이 사용됩니다.

최근에는 GLUE의 휴먼 베이스라인을 넘은 모델들이 많이 개발되었습니다. 그래서 지난 8월에 더 어려운 문제들로 구성된 SuperGLUE가 새롭게 공개되기도 했습니다.