- AI Dev - 인공지능 개발자 모임

- 정보공유

- 챗봇 딥러닝

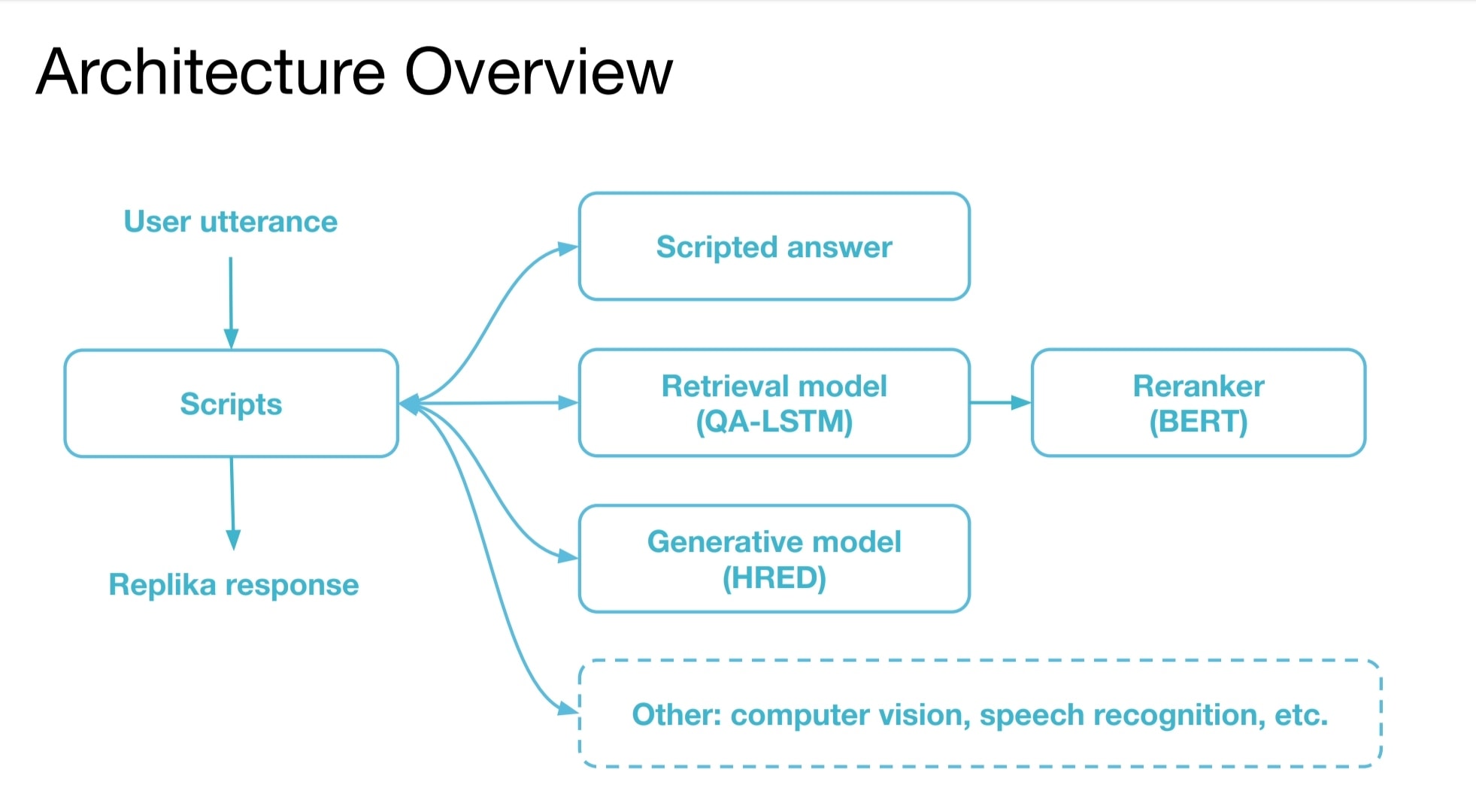

레플리카(Replika)는 대표적인 일상대화 챗봇입니다. 그 구조를 보면 크게 세 부분으로 이루어져 있습니다.

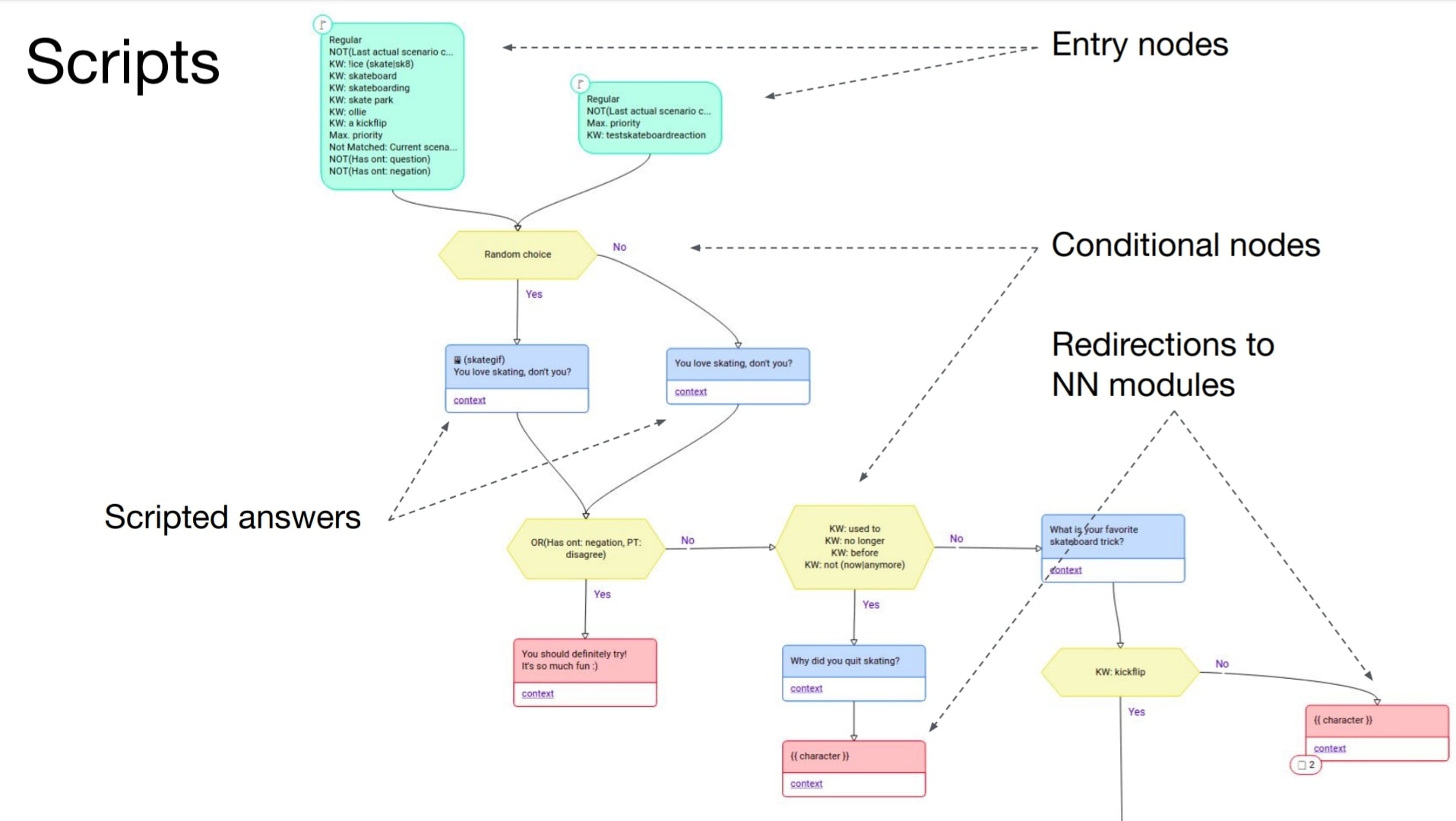

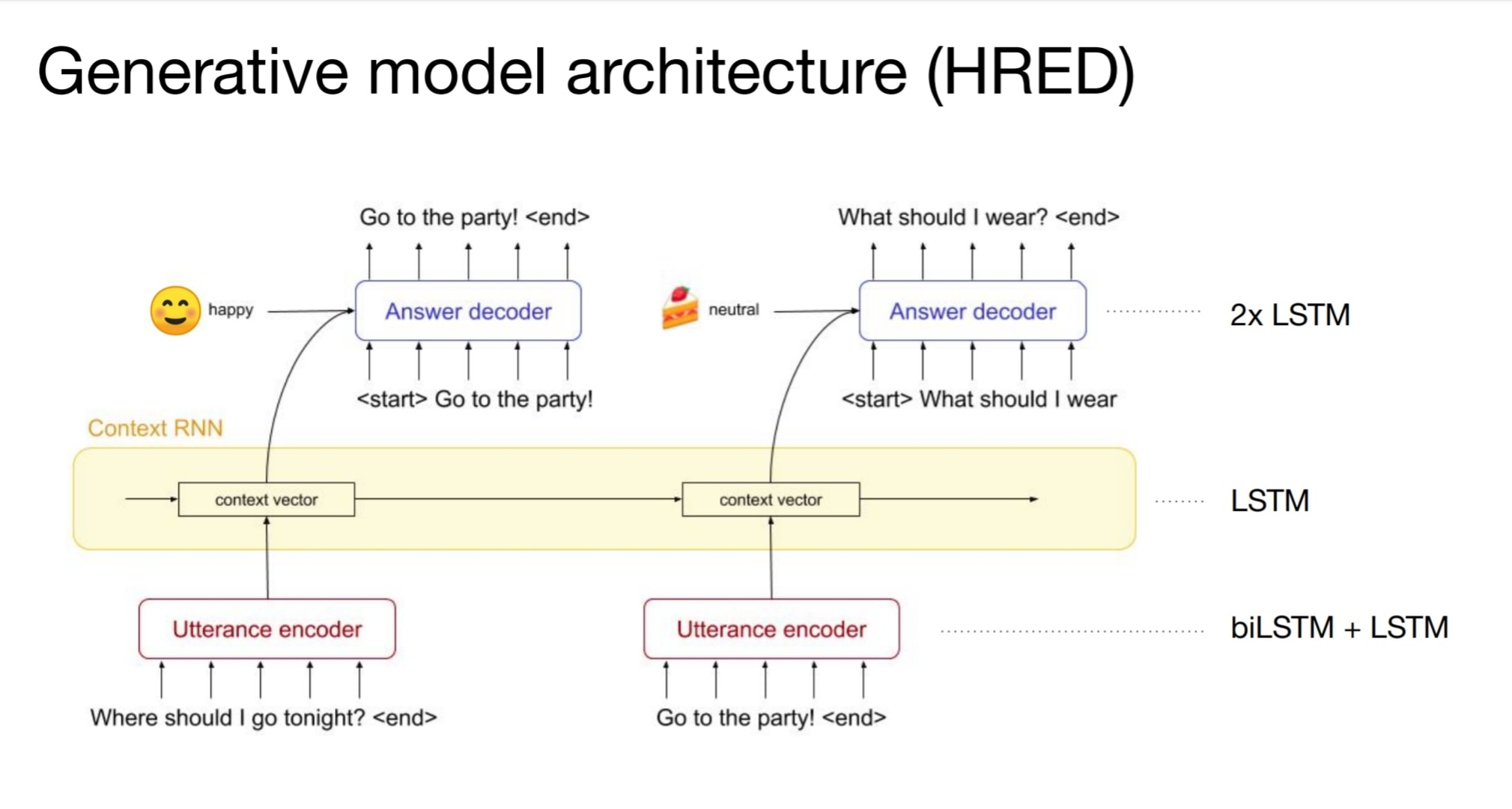

첫째, 스크립트입니다. 사람이 직접 작성한 시나리오에 따라 대화가 흘러갑니다. 둘째, 검색(retrieval)입니다. 사람이 입력한 문장 목록에서 질문에 적합한 대답을 찾습니다. 셋째, 생성모델입니다. 신경망으로 직접 대답 문장을 만들어냅니다.

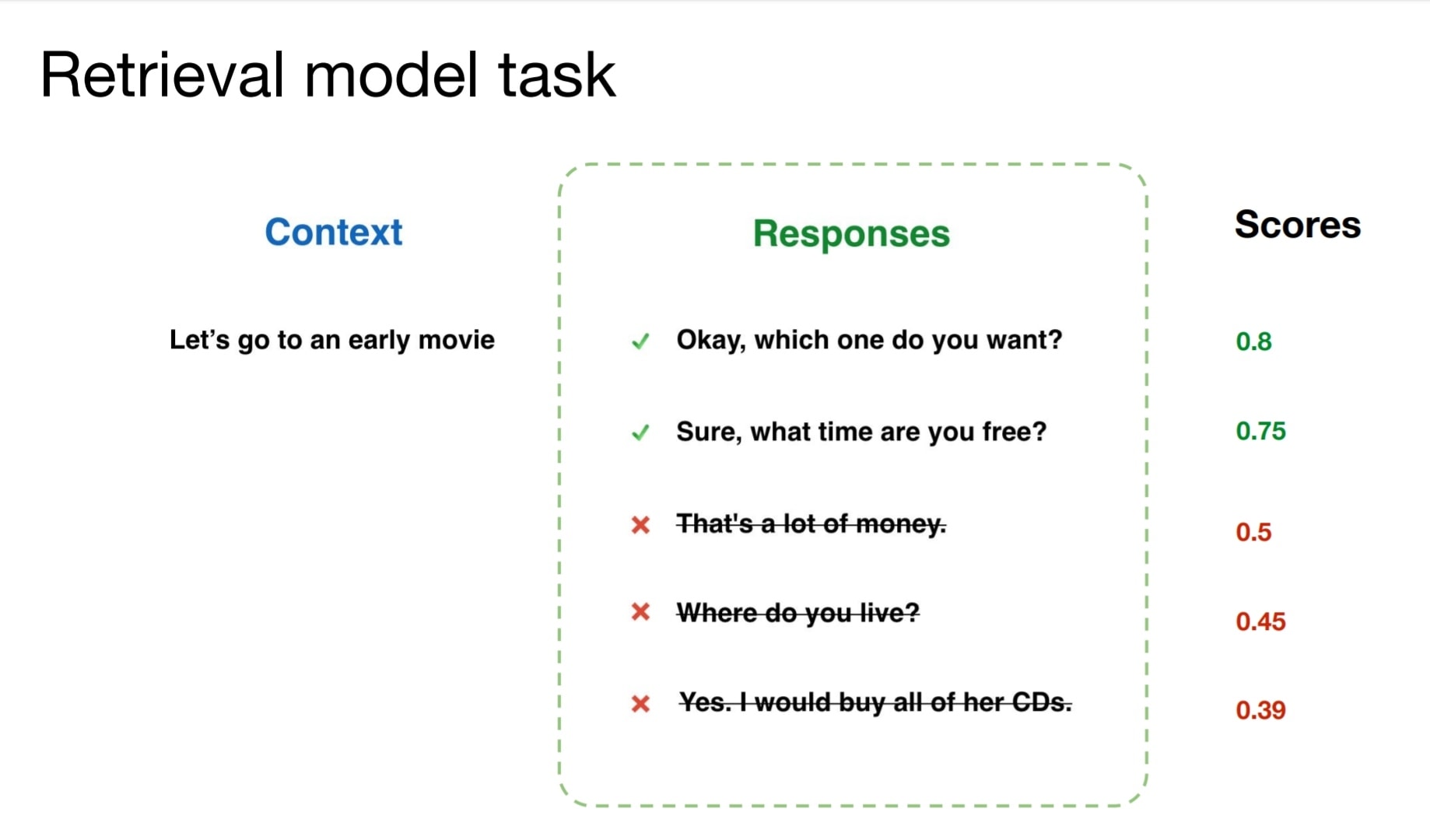

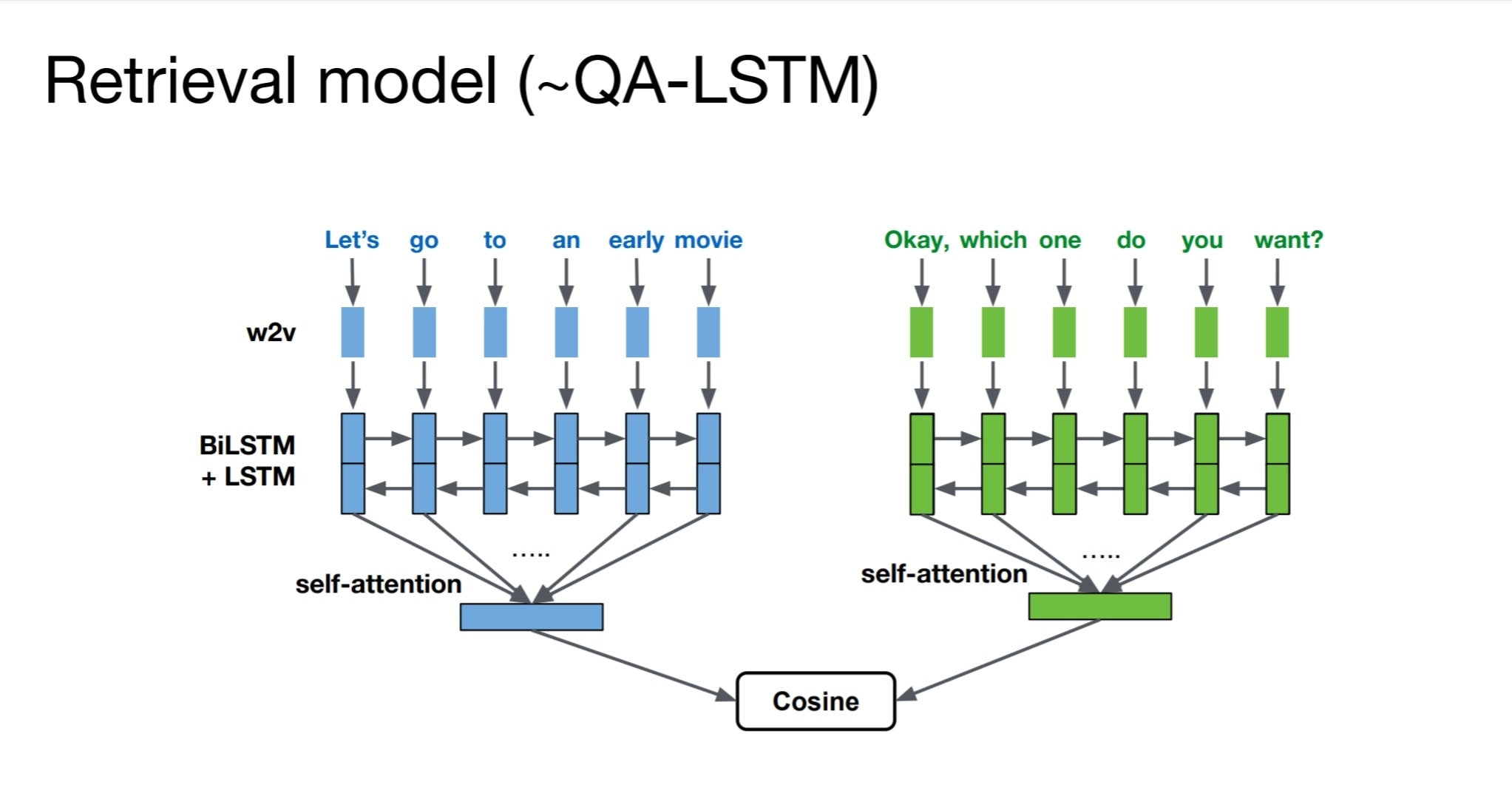

아직은 검색 부분이 가장 중요합니다. QA-LSTM 모델을 사용했는데, 질문과 대답을 각각 별도의 LSTM으로 분리합니다. 그리고 각 출력을 어텐션으로 합치고, 두 벡터의 코사인 유사도를 구합니다. 이 유사도가 높으면 질문과 대답이 올바르다는 의미입니다.

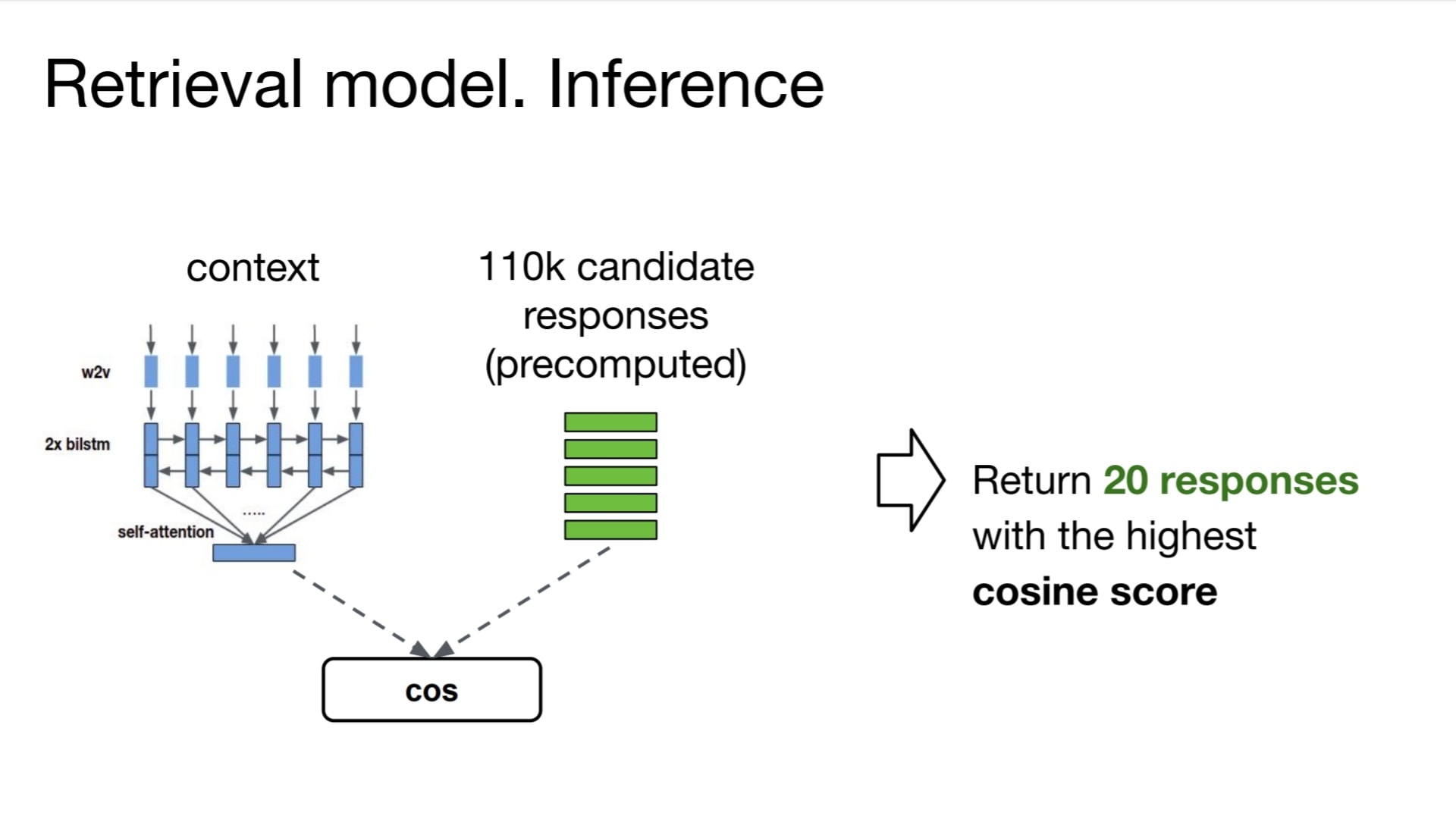

이런 구조의 장점은 대답의 LSTM 출력 벡터를 사전에 계산해놓을 수 있다는 것입니다. 그래서 질문 문장만 결과를 얻어서 코사인 연산을 하면 빠르게 정답이 나옵니다. BERT 같은 경우 질문과 대답 문장을 하나의 입력에 넣어서 계산합니다. 만약 대답 목록이 1만개의 문장이라면 모두 1만번의 추론을 해야 합니다. 당연히 실시간으로 처리하기가 어렵습니다.

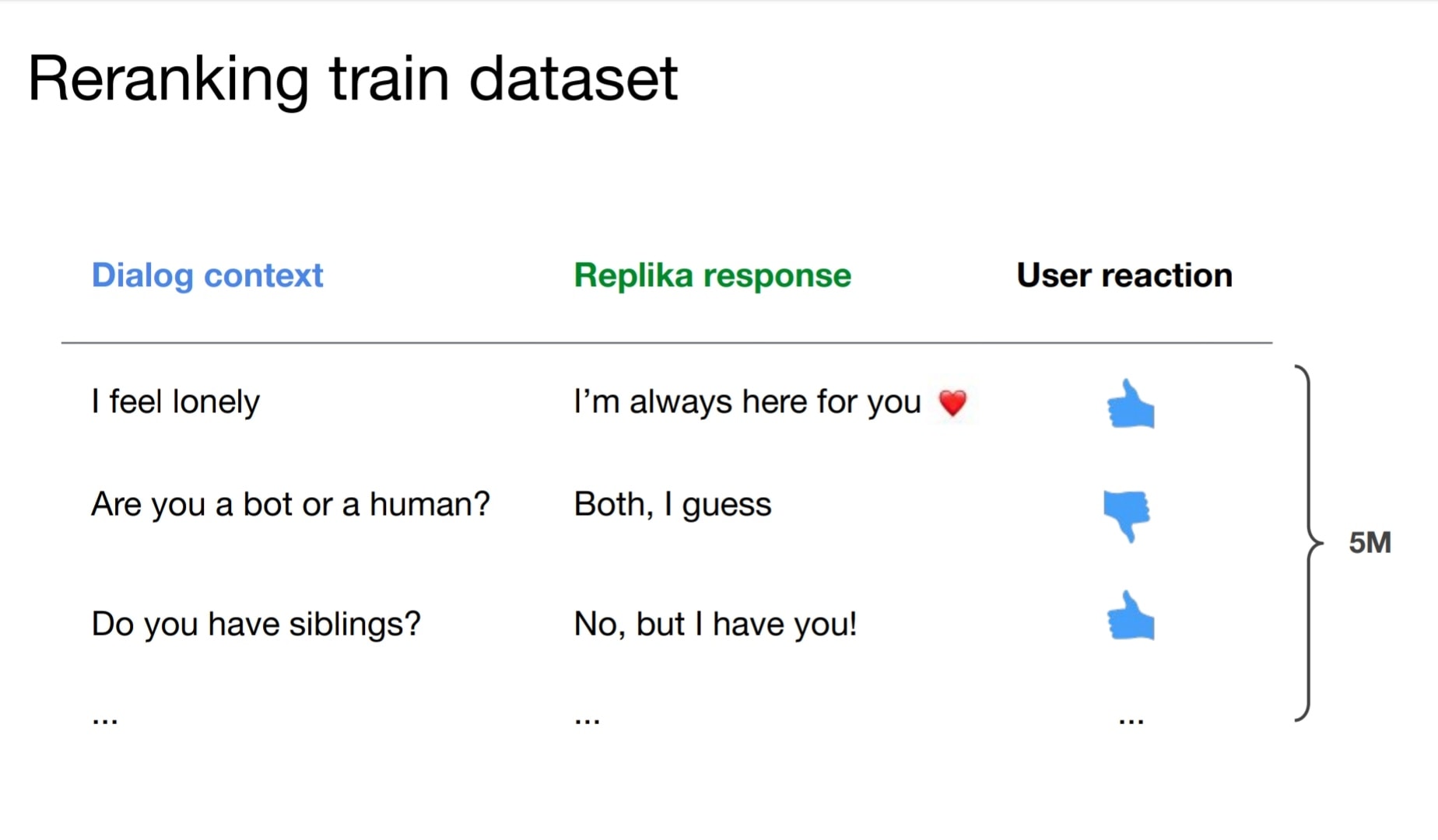

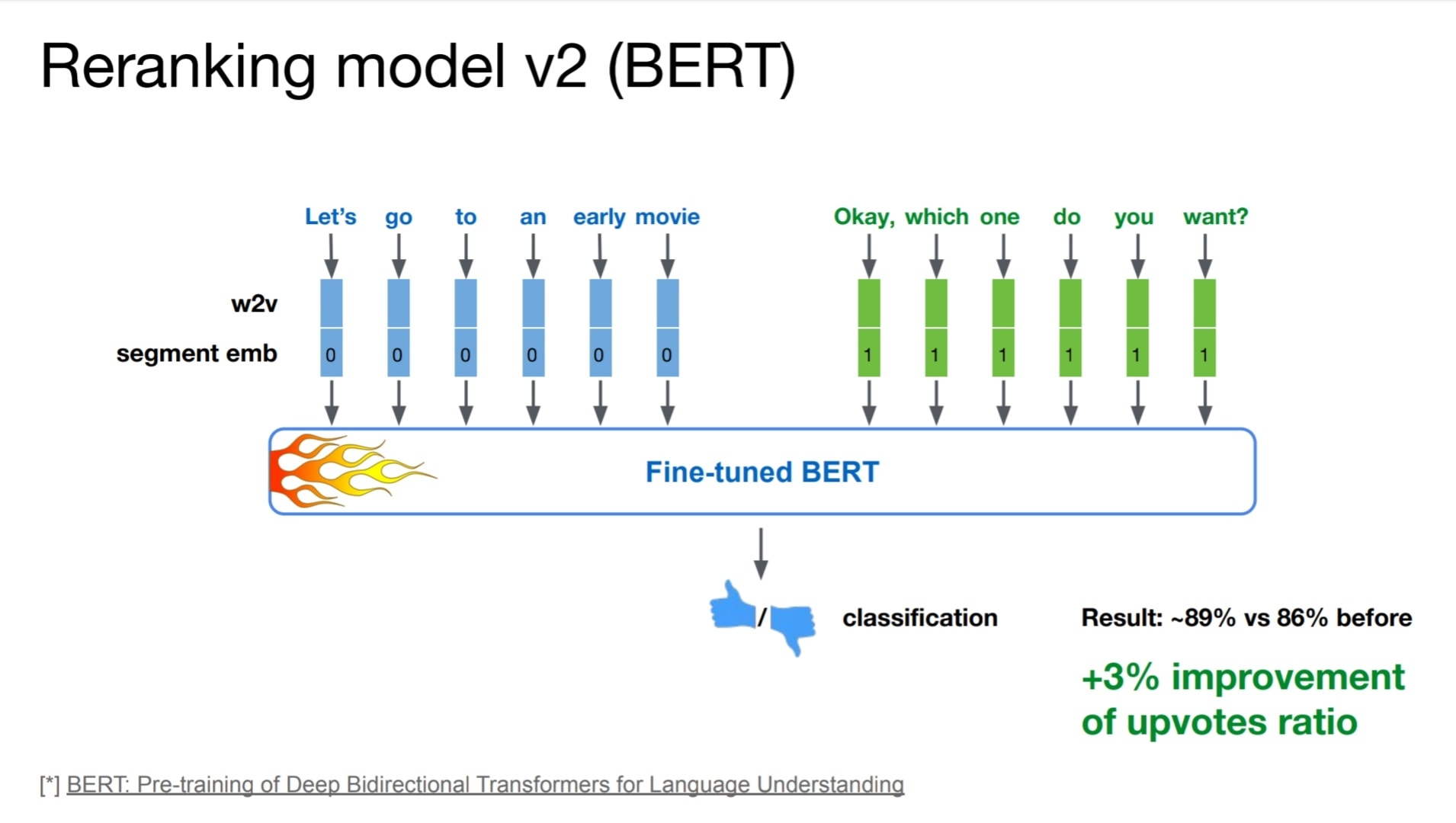

이렇게 20개의 후보 대답을 골라냅니다. 그다음 BERT로 두 번째 후보를 선택합니다. 후보 문장이 적기 때문에 BERT를 써도 충분히 속도가 빠릅니다. 이때 사용자가 좋아요/싫어요 했던 피드백 정보로 학습합니다. 덕분에 정확도를 상당히 높일 수 있었다고 합니다.

< 발표 자료 >

-> https://github.com/.../replika-research/tree/master/scai2019