- AI Dev - 인공지능 개발자 모임

- 정보공유

- 챗봇 딥러닝

글 수 283

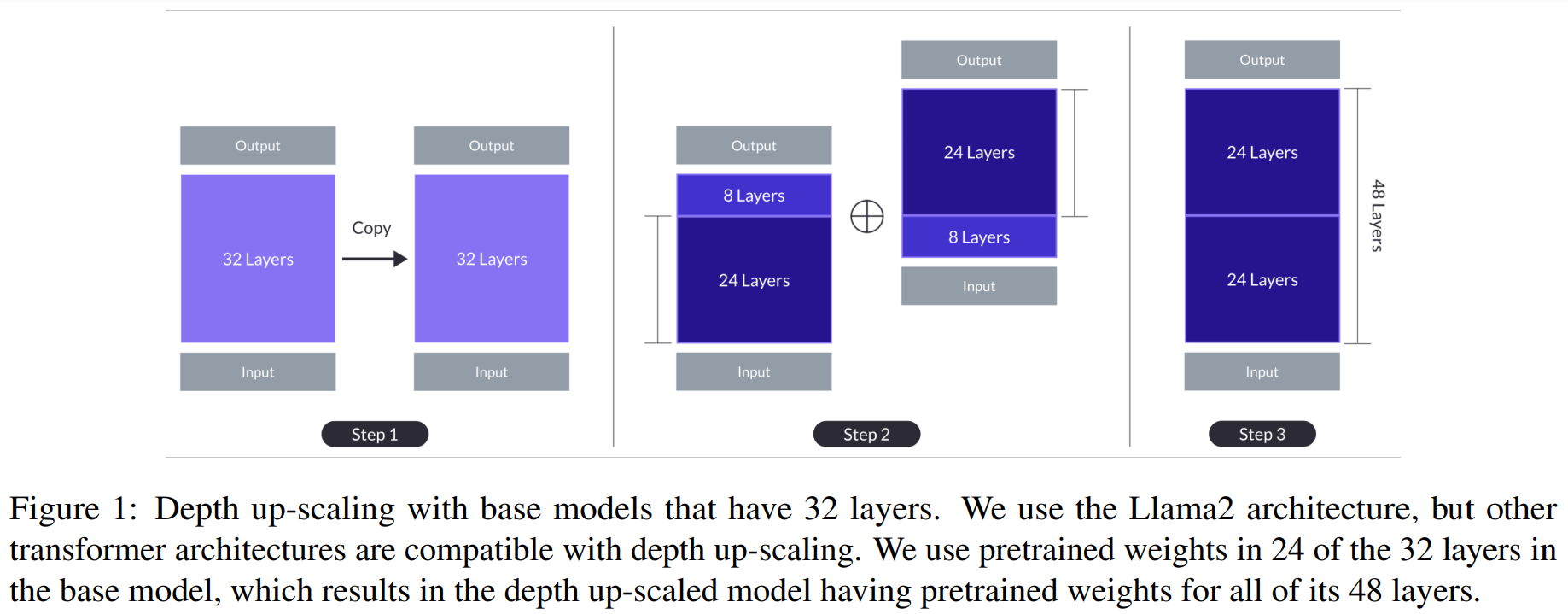

업스테이지 SOLAR 10.7B 모델의 논문이 나왔습니다. DUS(Depth Up-Scaling)이라는 새로운 기법을 사용했습니다. 먼저 Llama2 아키텍처인 Mistral 7B 모델을 베이스 모델로 가져옵니다. 이 모델을 2개로 복사하고 각각 위쪽 8개 레이어와 아래쪽 8개 레이어를 제거합니다. 그다음 두 모델을 붙여서 총 48 레이어의 하나의 모델로 만듭니다.

이 상태에서는 기존 Mistral 7B보다 모델 크기는 10.7B으로 커졌지만 성능이 떨어집니다. 그래서 다시 pretraining을 한번 하고 Instruction tuning과 Alignment tuning 과정을 거칩니다. Instruction tuning은 QA 데이터로 파인튜닝을 합니다. Alignment tuning은 DPO(Direct Preference Optimization)를 사용합니다. 이는 RLHF과 유사하지만 reward가 필요없는 방법입니다.

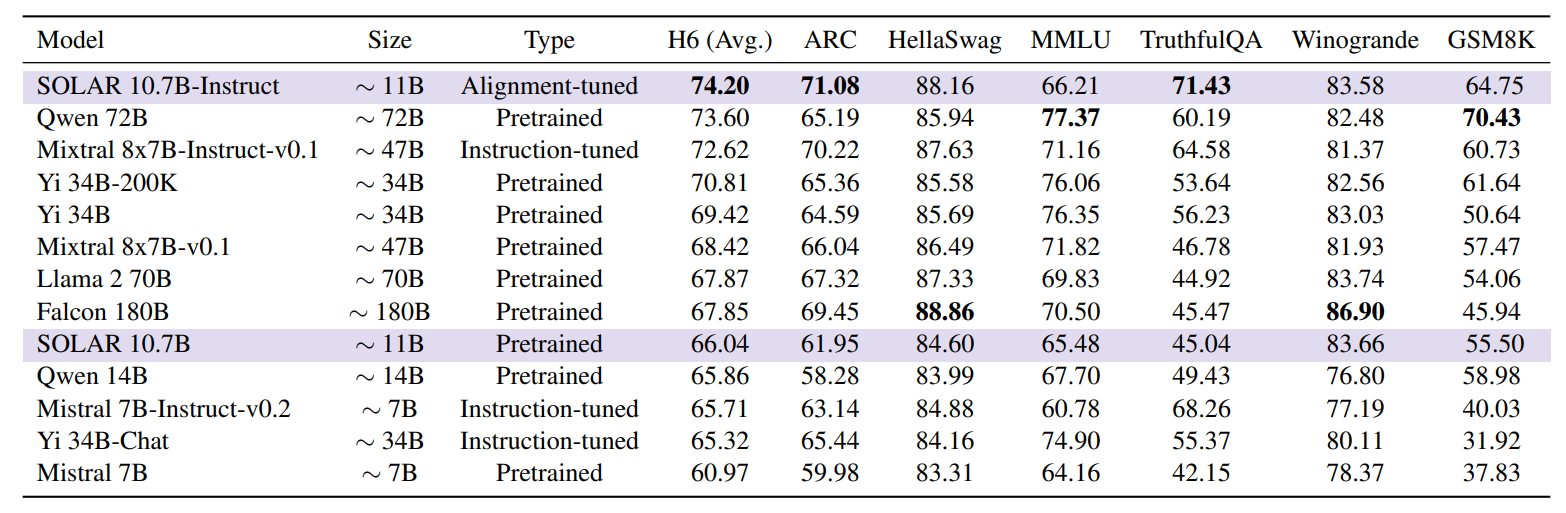

정리하면 7B의 사전훈련된 모델을 두개로 복사하여 붙여서 모델의 크기를 키우고 다시 추가 학습을 했습니다. GPT-4에서 쓰인 MoE(Mixture of Experts) 보다 구조가 훨씬 간단하면서 효율적으로 성능을 높일 수 있습니다. 벤치마크를 보면 MoE 기반의 Mixtral 8x7B보다 점수가 더 높게 나왔습니다. 업스테이지의 기술력이 놀랍네요. SOLAR가 한국을 대표하는 LLM으로 발전했으면 합니다.

< 논문 >

https://arxiv.org/abs/2312.15166