- AI Dev - 인공지능 개발자 모임

- 정보공유

- 챗봇 딥러닝

글 수 282

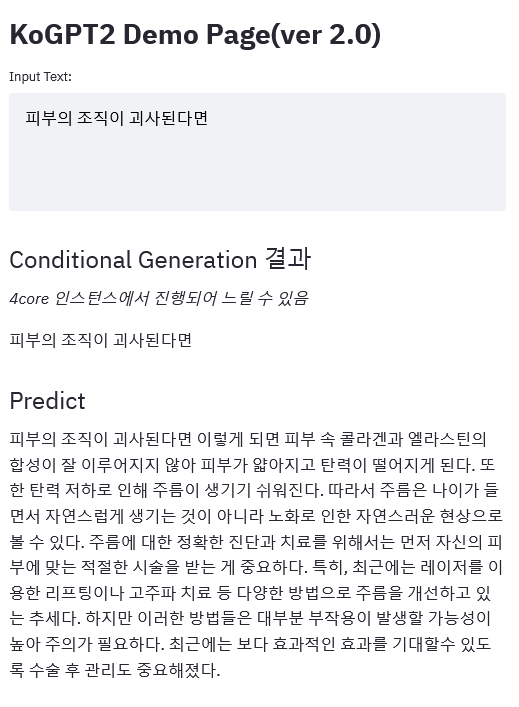

https://github.com/SKT-AI/KoGPT2

https://huggingface.co/skt/kogpt2-base-v2

지난 5월에는 SKT의 KoGPT2 v2.0 모델이 공개됐습니다. 학습에 사용된 데이터셋이 기존 20GB에서 40GB으로 두 배 증가했고, 혼잡도(Perplexity)도 45% 감소했습니다.

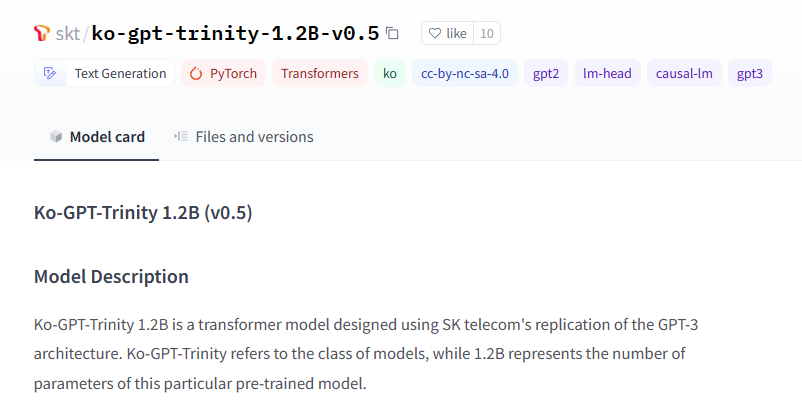

https://huggingface.co/skt/ko-gpt-trinity-1.2B-v0.5

마찬가지로 5월에 GPT-3의 구조를 모방한 Ko-GPT-Trinity라는 모델이 공개됐습니다. 파라미터의 수가 1.2B로 125M이었던 KoGPT2에 비해 크게 늘어났습니다.

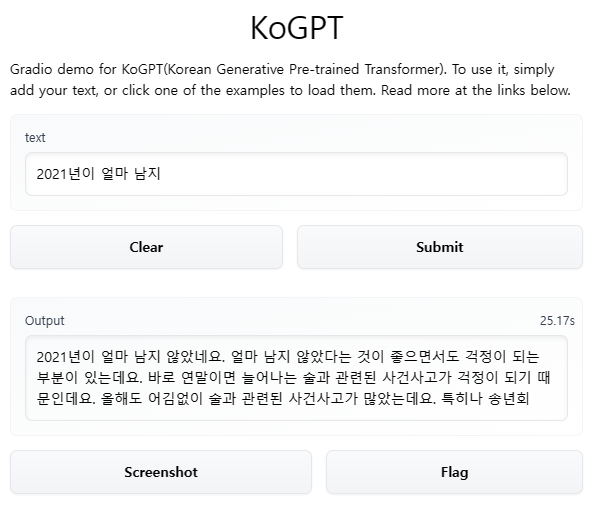

https://github.com/kakaobrain/kogpt

https://huggingface.co/kakaobrain/kogpt

https://huggingface.co/spaces/akhaliq/kogpt

그리고 며칠 전 카카오에서도 GPT 모델을 공개했습니다. 파라미터의 수가 6B로 가장 큽니다. 카카오는 앞으로 GPT 모델의 크기와 성능을 100배 규모로 키울 예정이라고 밝혔습니다.

좋은 정보 감사합니다!