- AI Dev - 인공지능 개발자 모임

- 정보공유

- 챗봇 딥러닝

글 수 283

https://github.com/HAETAE-project/HAE-TAE-Catalog

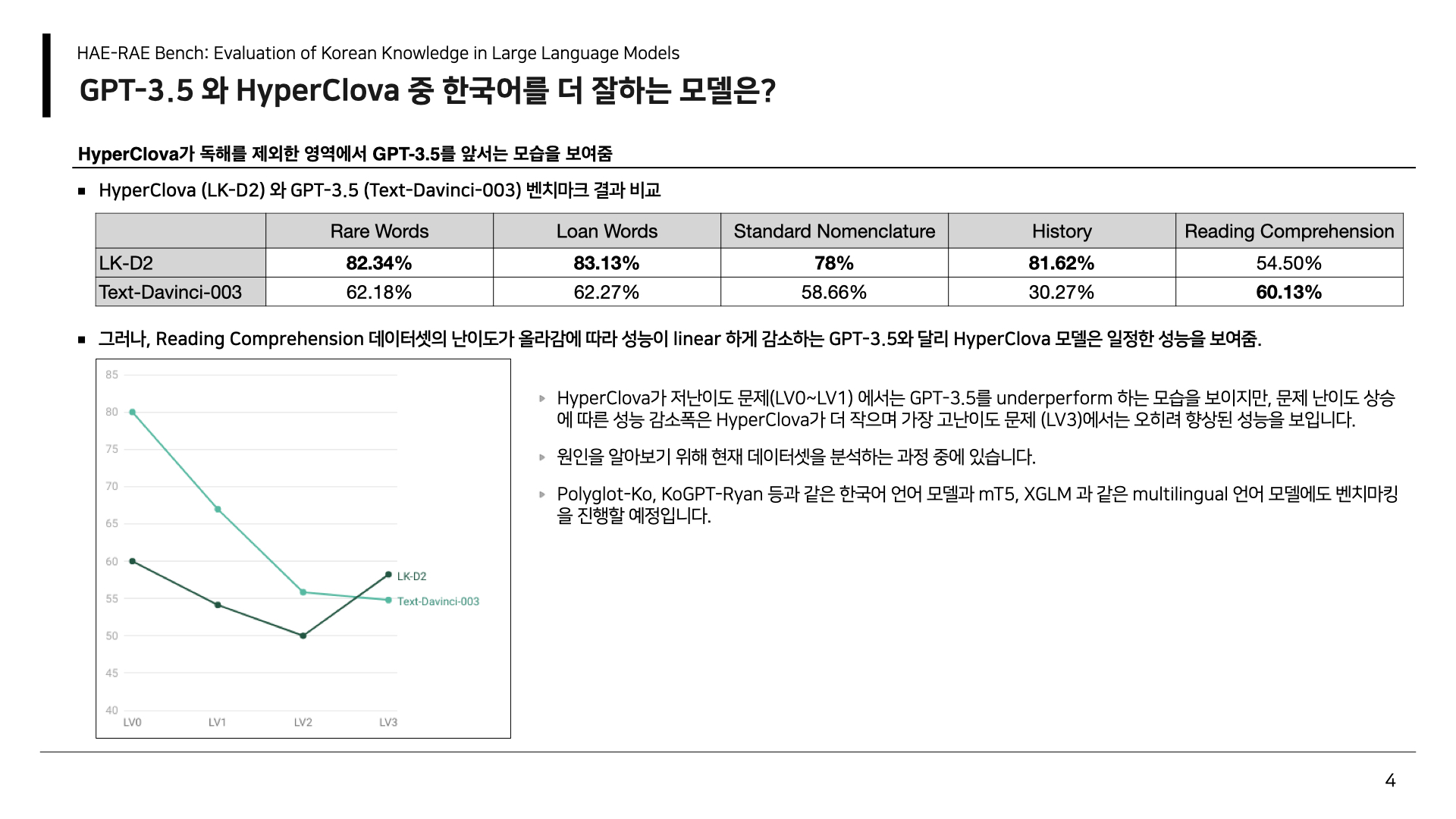

한국어 어휘, 독해, 문법, 지식 총 4가지 영역에서 GPT-3.5와 하이퍼클로바의 성능을 비교했다고 합니다. 독해에서는 GPT-3.5가 60.13%, 하이퍼클로바가 54.5%로 약간 앞섭니다. 하지만 나머지에서는 모두 하이퍼클로바가 우위에 있네요. 특히 역사에서는 50% 이상 차이가 납니다. 역시 한국 콘텐츠에 대한 학습 데이터가 중요한 것 같습니다.