- AI Dev - 인공지능 개발자 모임

- 정보공유

- 챗봇 딥러닝

https://tykimos.github.io/2017/08/17/Text_Input_Binary_Classification_Model_Recipe/

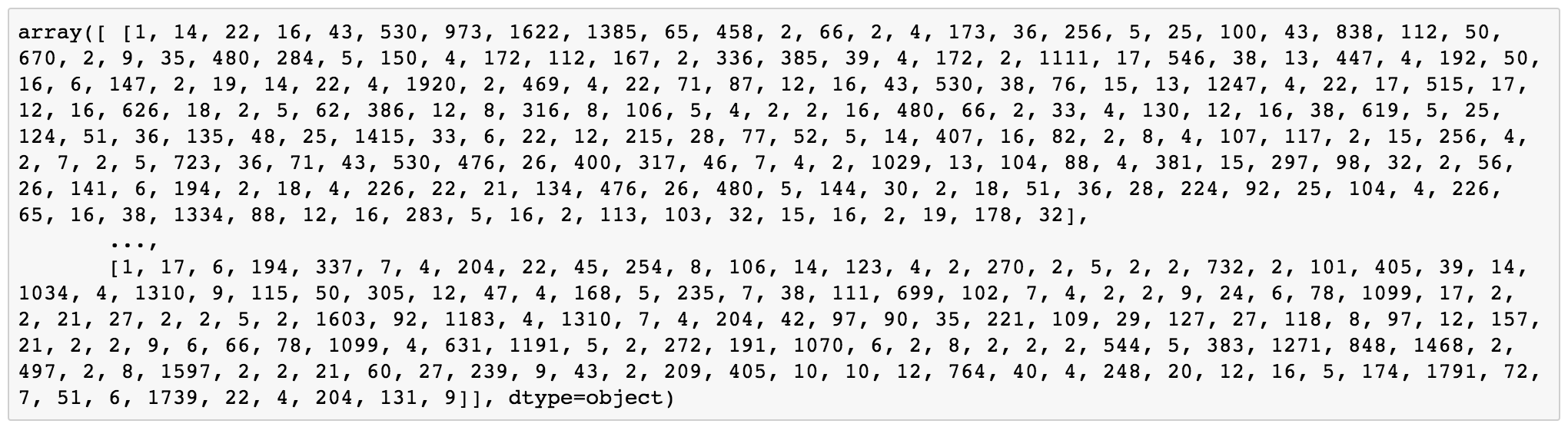

영화정보 사이트인 IMDb의 영화평점 데이터를 사용해서 케라스로 학습하는 코드입니다. 자연어를 어떻게 벡터로 임베딩을 하는지 간단하게 설명해 보겠습니다.

먼저 데이터셋에 있는 모든 단어를 빈도수에 따라 정렬하고 ID를 부여합니다. 보통 편의를 위해서 최대 단어수를 지정합니다. 여기서는 5개의 단어만 존재한다고 가정하고 빈도수는 임의로 설정하겠습니다.

--------------------

love -> 0

i -> 1

so -> 2

you -> 3

much -> 4

--------------------

그리고 문장의 단어를 ID로 변환합니다.

----------------------------

i love you so much

-> [1, 0, 3, 2, 4]

----------------------------

만약 단어의 수가 적다면 다음과 같이 간단하게 각각의 ID를 벡터로 지정하는 One-Hot Encoding으로 변환할 수도 있습니다.

-------------------------------------

i -> (0, 1, 0, 0, 0)

love -> (1, 0, 0, 0, 0)

you -> (0, 0, 0, 1, 0)

so -> (0, 0, 1, 0, 0)

much -> (0, 0, 0, 0, 1)

-------------------------------------

하지만 보통은 차원의 수를 줄이기 위해 임베딩 함수를 이용합니다. 전체 단어수는 5, 임베딩 벡터 크기는 3, 한 문장의 단어 개수는 5일때 아래와 같이 구현을 합니다.

----------------------------------------------------------------

model.add(Embedding(5, 3, input_length=5))

----------------------------------------------------------------

임베딩의 초기값은 랜덤하게 지정이 되고 학습을 통해 조금씩 업데이트 됩니다. Word2Vec 같은 방식을 사용하여 초기값을 설정할 수도 있습니다.

---------------------------------

i -> (0.5, 0.1, 0.7)

love -> (0.2, 0.6, 0.3)

you -> (0.9, 0.7, 0.5)

so -> (0.4, 0.7, 0.1)

much -> (0.3, 0.4, 0.5)

i love you so much

-> {[0.5, 0.1, 0.7], [0.2, 0.6, 0.3], [0.9, 0.7, 0.5], [0.4, 0.7, 0.1], [0.3, 0.4, 0.5]}

---------------------------------

seq2seq 예시를 만들었는데 임베딩 레이어를 넣어보려고 했더니 정작 디코딩은 어떻게 해야할지 모르겠더라구요. 임베딩한 값을 다시 단어로 바꾸려면 뭐라고 검색을 해봐야 할까요 ㅠ