- AI Dev - 인공지능 개발자 모임

- 정보공유

- 챗봇 딥러닝

ChatGPT의 가장 큰 단점은 환각(hallucination)입니다. 자기가 모르는 사실은 적당히 지어내서 얘기합니다. 그래서 언뜻 그럴듯해 보이지만 실제로는 잘못된 정보일 경우가 많습니다.

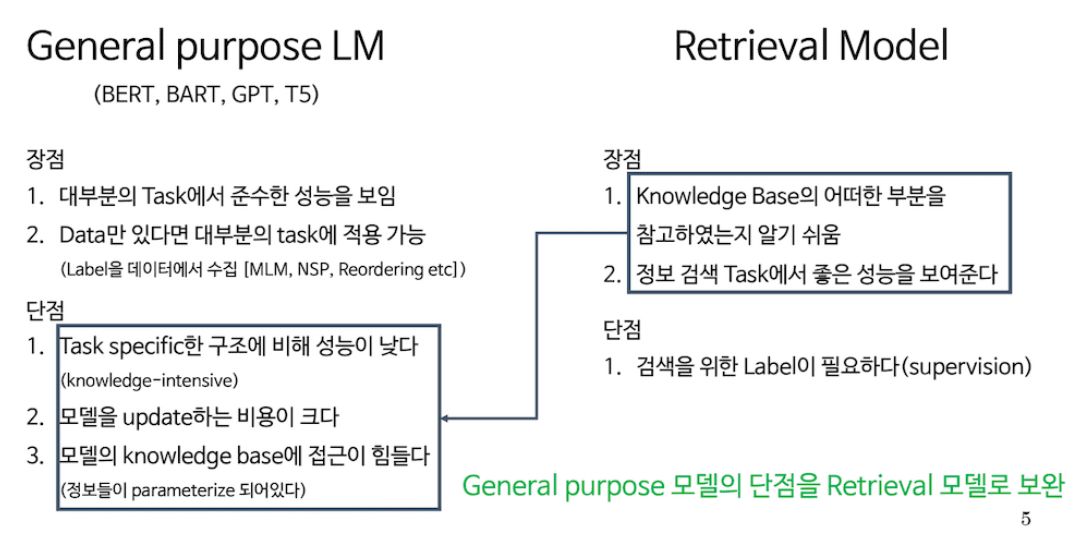

이런 문제를 해결하는 첫 번째 방법은 파인튜닝입니다. 특정 도메인의 새로운 데이터로 추가 학습을 합니다. 초거대AI일 경우 전체 파라미터를 모두 업데이트하기는 어렵습니다. 그래서 P-tuning이나 LoRA 같이 일부 파라미터만 학습하는 방식을 사용합니다. 다만 아직 ChatGPT는 파인튜닝 기능이 없습니다.

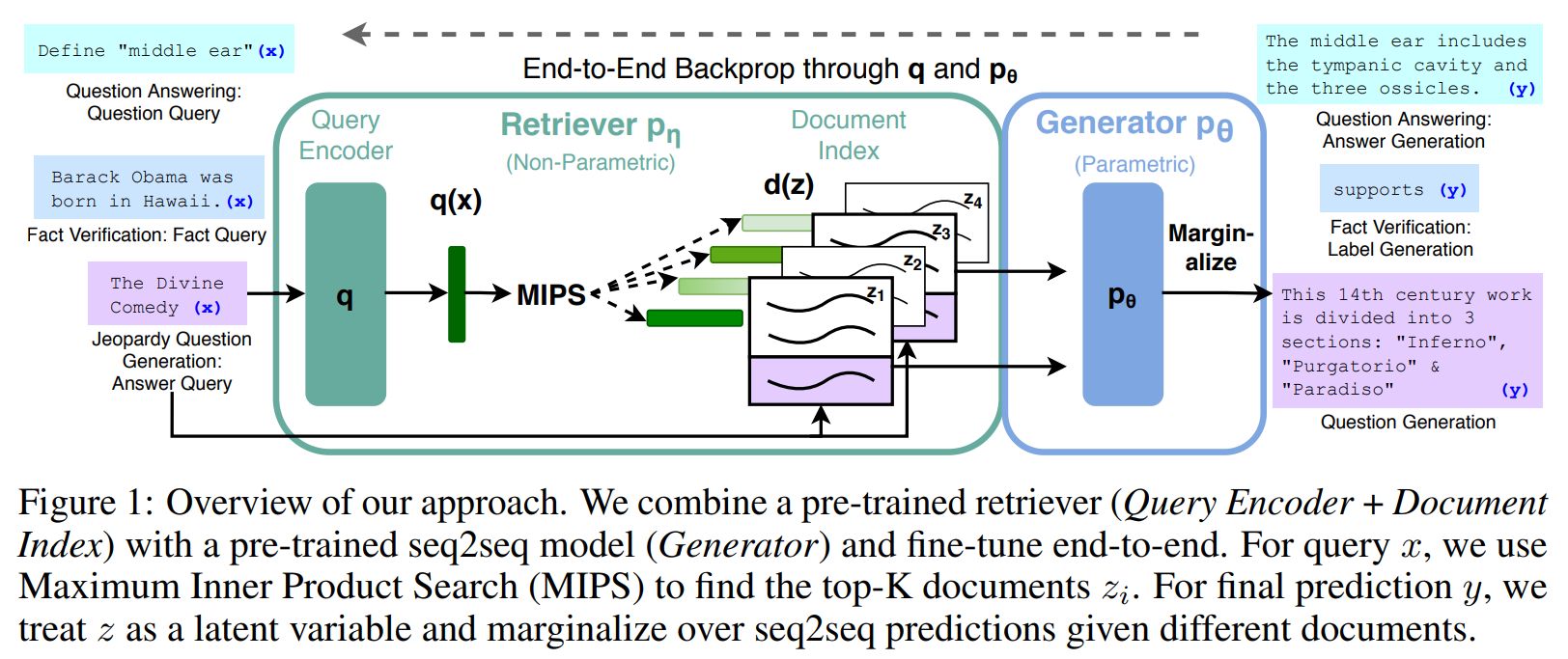

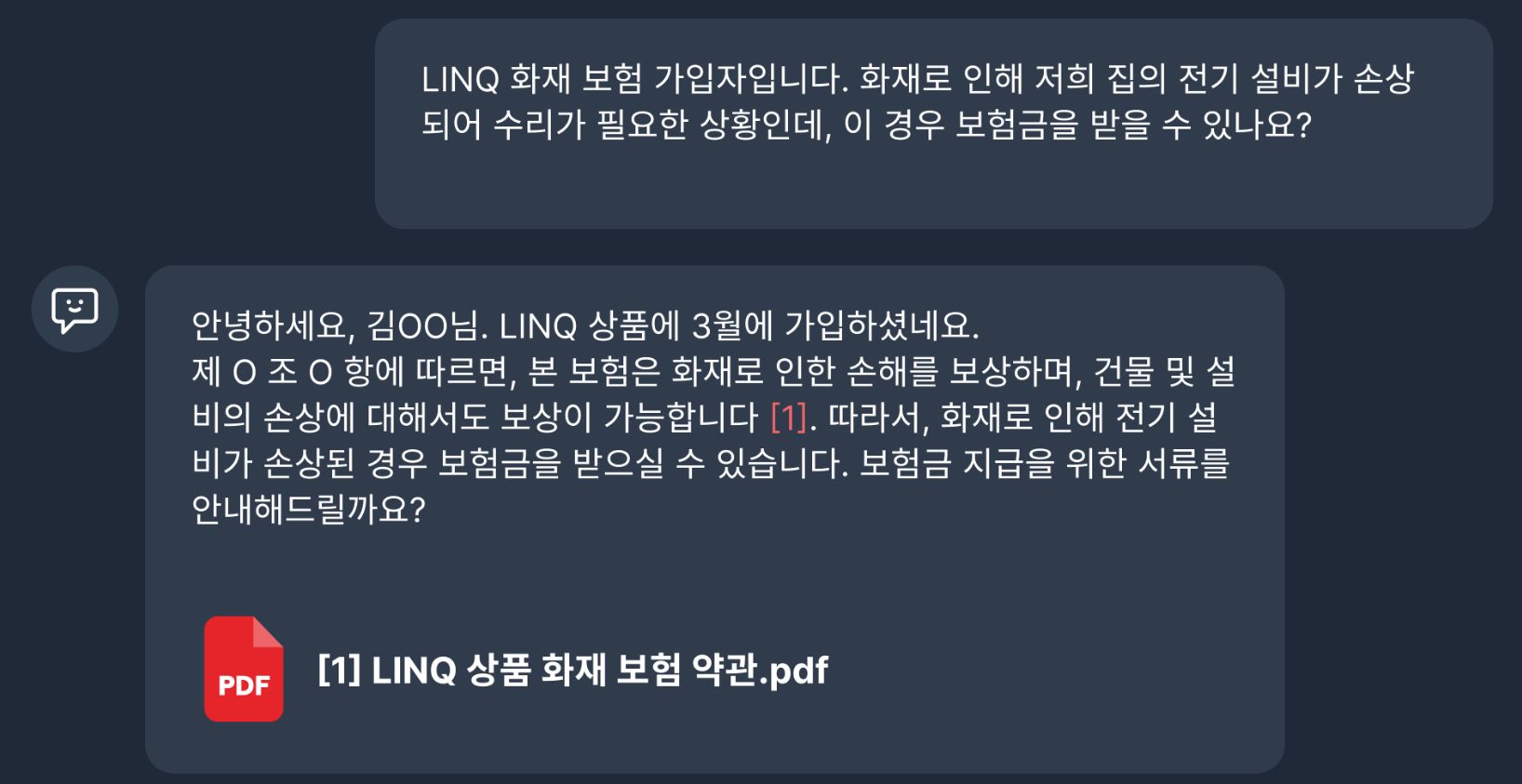

두 번째 방법은 RAG(Retrieval-Augmented Generation)입니다. LLM에게 미리 질문과 관련된 참고자료를 알려줍니다. 이렇게 하면 환각을 줄이고 보다 정확하게 대답을 생성할 수 있습니다. ChatPDF가 대표적인 예입니다. PDF 문서를 업로드하고 질문을 하면, PDF에서 해당하는 정보를 찾아서 대답을 해줍니다.

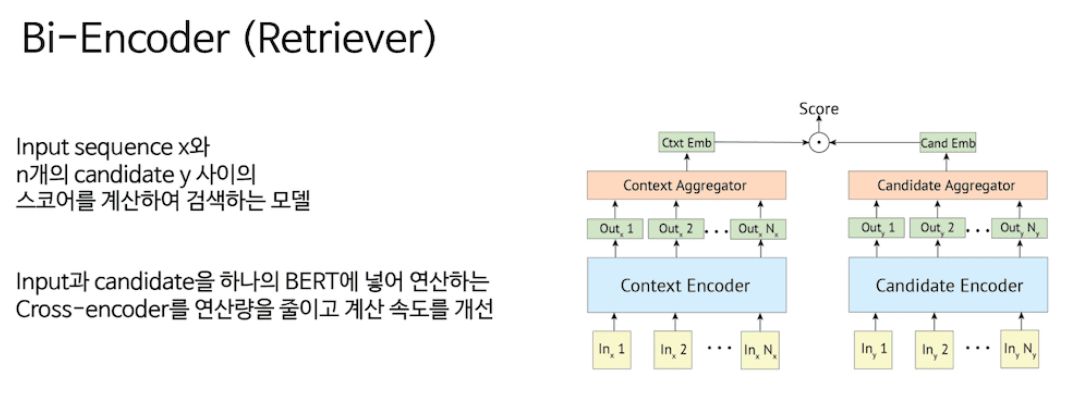

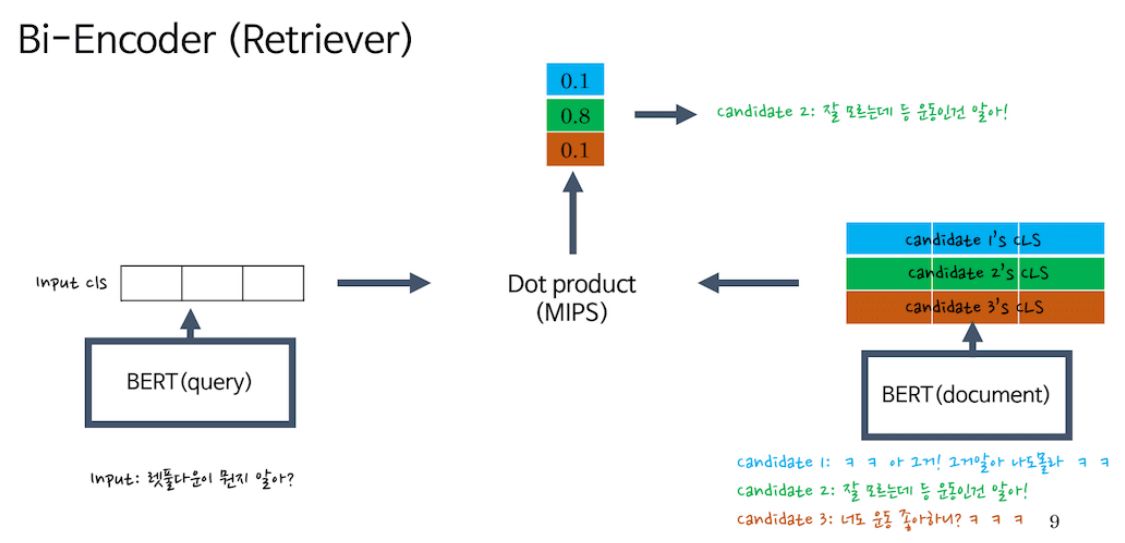

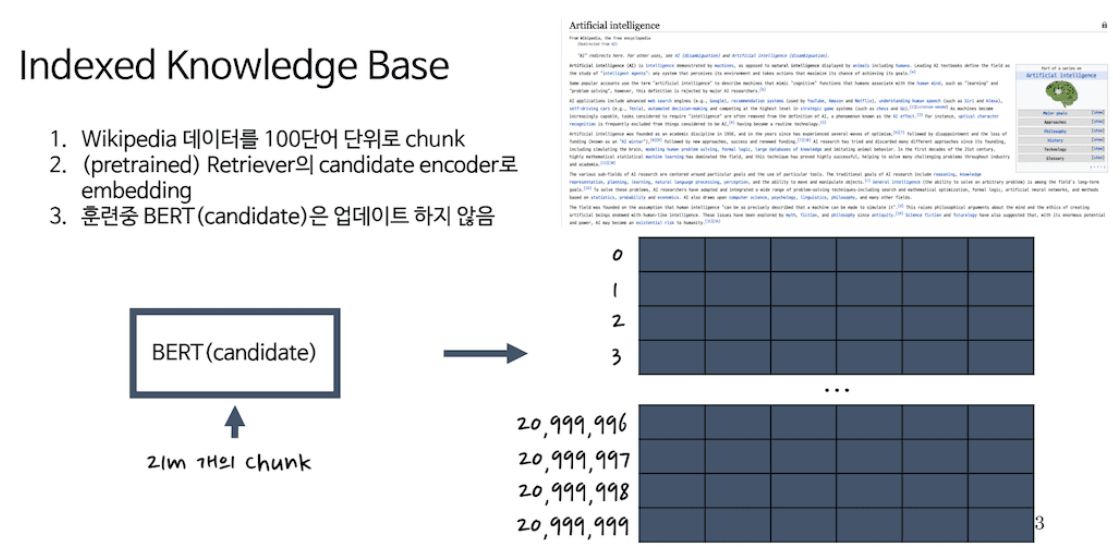

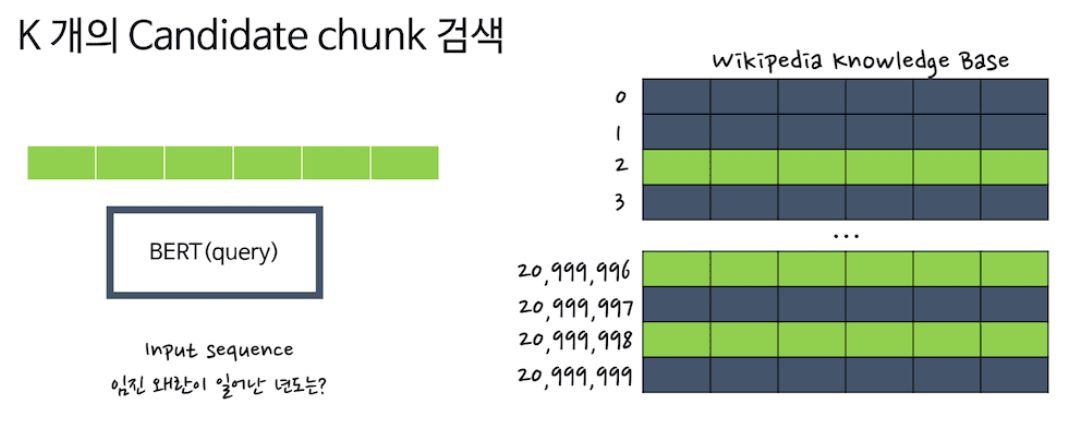

RAG를 하기 위해선 먼저 지식베이스를 만들어야 합니다. 위키피디아일 경우 100단어 단위로 잘라서 단락으로 구분합니다. 그리고 벡터로 임베딩한 후 벡터DB에 넣습니다. 질문을 하면 이 문장 역시 임베딩으로 변환하고, 벡터DB에서 가장 유사한 단락을 찾습니다. 검색한 단락과 질문을 같이 프롬프트에 넣고 LLM에 입력하면 대답이 생성됩니다. 논문에서는 Bi-Encoder로 임베딩을 했지만, 요즘은 OpenAI Enbeddings를 주로 씁니다.

이런 RAG 기법은 LLM을 당장 기업에서 도입할 수 있는 가장 손쉬운 방법입니다. 이미 관련 스타트업도 상당수 있는 걸로 알고 있습니다. 예전 챗봇 회사들이 SI로 챗봇 만들어주는 것과 비슷합니다. Wecover란 곳에서는 장기기억까지 적용해서 사내 또는 고객대응 LLM 챗봇을 만들어주고 있습니다. 사용자의 프로필 정보나 이전에 했던 말을 기억해서 대답을 하면 더욱 유용해집니다. 이렇게 개인화된 서비스 역시 필수적이 될 것입니다.

< Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks >

https://arxiv.org/abs/2005.11401

< 논문 리뷰 >

https://cobslab.com/retrieval%EC%9D%98-%ED%9A%A8%EA%B3.../

< Embedding이란 무엇이고, 어떻게 사용하는가? >

https://today-gaze-697915.framer.app/.../what-is...

< ChatPDF >

< Wecover >