- AI Dev - 인공지능 개발자 모임

- 정보공유

- 챗봇 딥러닝

글 수 284

https://brunch.co.kr/@gentlepie/62

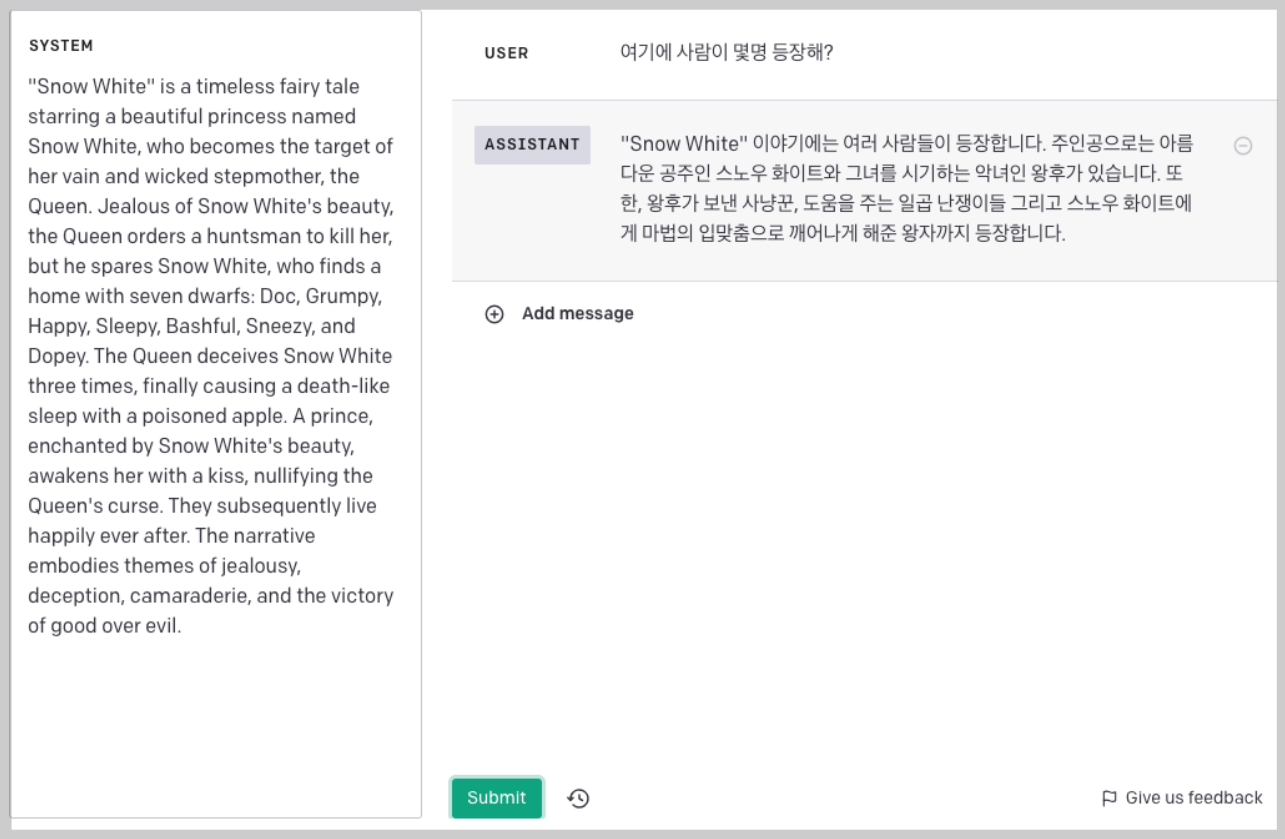

LLM은 모델의 크기가 커지면서 개발자도 예측하지 못한 창발적인 현상이 생겼습니다. 그중 하나가 CoT(Chain of thought)입니다. 이에 대해 간략히 설명한 글입니다.

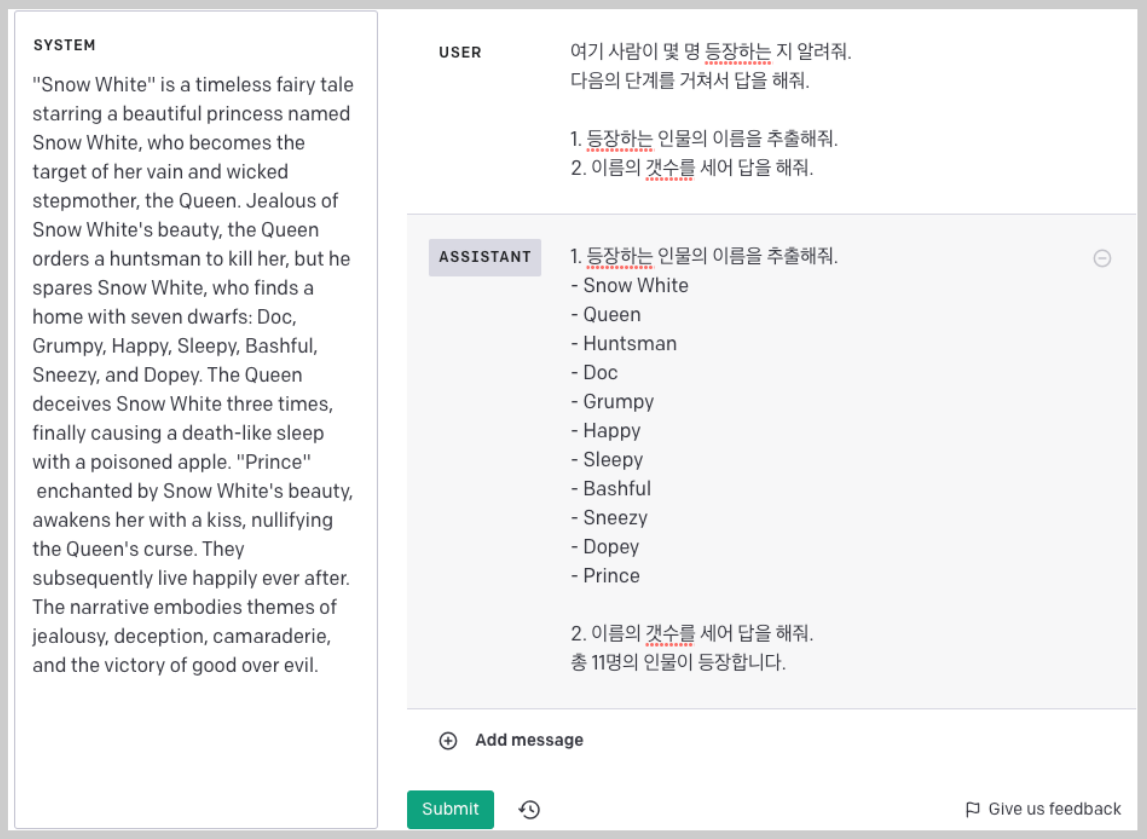

GPT-3에서 Let's think step by step이란 프롬프트만 추가해도 정확도가 크게 향상된다는 논문도 있었습니다. 이런 단계를 사람이 명시적으로 알려주면 더욱 효과적입니다.

LLM은 이렇게 task를 단계적으로 나눌 때 더 잘 동작하는 것 같습니다. AutoGPT 역시 CoT와 비슷하게 해야할 일을 먼저 순서대로 나열합니다. 그리고 각각의 일을 하나씩 이어서 실행하고 최종 결과를 사용자에게 전달합니다. 사실 이건 CoT라기 보다는 Planning에 가깝지만요.