- AI Dev - 인공지능 개발자 모임

- 정보공유

- 챗봇 딥러닝

어제 구글 I/O에서 발표한 구글 듀플렉스(Google Duplex)입니다. 레스토랑이나 미용실에 예약을 대신 할 수 있는 인공지능으로 구글 어시스턴트에서 명령을 내리면 자동으로 전화를 걸어 예약을 해줍니다.

나 : 저녁 8시에서 9시 사이 강남 아웃백 두명 예약해줘

구글 어시스턴트 : 알겠습니다.

구글 듀플렉스 : 안녕하세요. 저녁 8시에 두명 예약하고 싶은데요.

아웃백 점원 : 8시는 안되고 8시 30분에는 가능합니다.

구글 듀플렉스 : 8시 30분도 괜찮습니다.

아웃백 점원 : 성함이 어떻게 되시죠?

구글 듀플렉스 : 홍길동입니다.

아웃백 점원 : 홍길동님 저녁 8시 30분에 예약 완료되셨습니다.

구글 듀플렉스 : 감사합니다.

구글 어스시턴트 : 저녁 8시 30분에 강남 아웃백 두명 예약을 하였습니다.

나 : 고마워

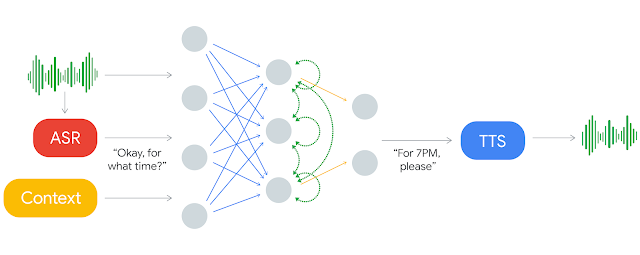

얼마전 서비스를 종료한 개인비서 챗봇인 페이스북M과 비슷하지만 예약이라는 좀 더 한정된 도메인에 집중한 것이 큰 차이입니다. 페이스북M은 자동화가 어려워서 결국 포기를 했는데 구글은 이걸 학습으로 구현하였습니다. RNN을 사용했다고 하는데 대화 히스토리(문맥)과 대화 파라미터(목적)을 함께 입력으로 넣어서 문장을 생성합니다.

< 입력 >

문장 : 8시는 안되고 8시 30분에는 가능합니다.

히스토리 : 8시 예약 요청

파라미터 : 8~9시 사이 두명

< 출력 >

문장 : 8시 30분도 괜찮습니다.

아마 위와 비슷한 방식으로 동작하지 않을까 합니다. 학습에 필요한 데이터를 어떻게 생성하였는지 궁금하네요. 사람이 일일이 각 문장마다 히스토리와 파라미터를 표시하지 않았을까요.

이런 목적지향의 대화흐름을 학습으로 구현하는게 어려울거라고 생각했는데 역시 구글이네요. 지금은 챗봇을 만들때 사람이 대화를 직접 설계하는데 조만간 딥러닝을 사용하여 자동으로 학습하는 방법으로 변할지도 모르겠습니다.

그런데 시간이나 장소, 숫자같은 엔터티를 어떻게 일반화하여 학습을 하는 걸까요. 별도로 태그로 변경하여 처리한 다음 출력 결과에 나온 엔터티 태그를 다시 실제 값으로 변환을 하는 건가요.

< 참고 자료 >

구글 블로그

-> https://ai.googleblog.com/…/duplex-ai-system-for-natural-co…

기사

-> http://thegear.co.kr/16063