- AI Dev - 인공지능 개발자 모임

- 정보공유

- 챗봇 딥러닝

글 수 283

https://speakerdeck.com/dreamgonfly/soseol-sseuneun-dib-reoning-pycon-korea-2018

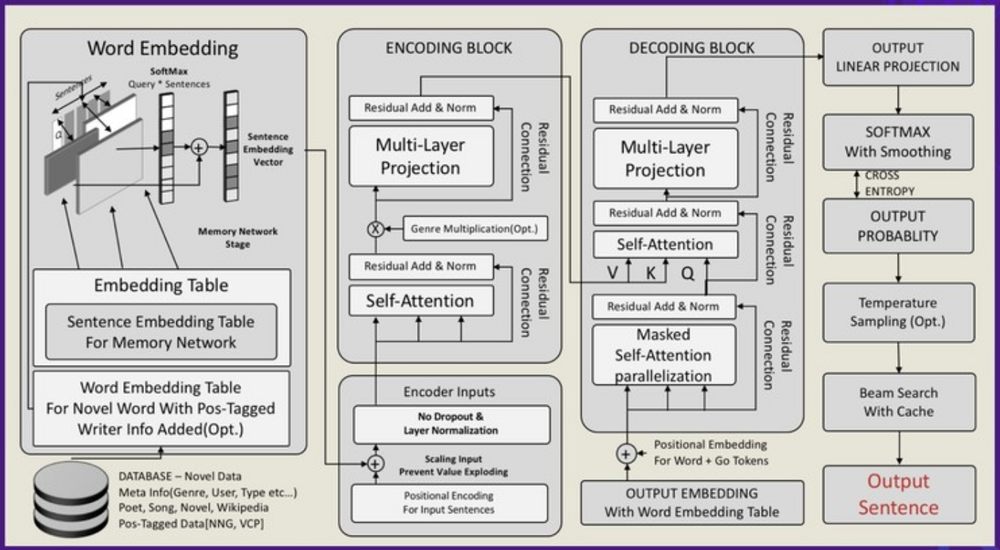

KT 인공지능 소설 공모전에서 최우수상을 받은 팀의 발표 자료입니다. 기본적으로 인코더-디코더의 방식인데 문장을 입력하면 새로운 문장이 나오는 end-to-end 구조입니다. RNN을 사용하지 않고 attention만으로 이루어진 transformer 모델을 기반으로 하고 거기에 메모리 네트워크를 추가하였습니다.

1. 유저가 처음 다섯 문장을 입력

2. 모델이 10개 후보 문장 생성

3. 유저가 후보 문장 중 한 문장 선택

4. 2번으로 반복

위와 같은 순서로 계속 문장을 만들어 나갔다고 합니다. 슬라이드 뒷부분에 실제 제출한 소설을 볼 수 있는데 전체적인 흐름면에서 완성도가 상당히 높습니다. 여러가지 소설이 섞인 다양한 데이터가 아니라 뭔가 통일된 형태의 정제된 데이터를 사용한 것이 아닐까 합니다.