- AI Dev - 인공지능 개발자 모임

- 정보공유

- 챗봇 딥러닝

글 수 283

https://blog.pingpong.us/electra-review

요즘 페이스북의 얀 르쿤이 항상 강조하는게 자기지도학습(self-supervised learning)입니다. 지도학습처럼 라벨이 필요한 것은 마찬가지입니다. 하지만 사람이 아니라 기계가 스스로 만든다는 차이가 있습니다. 이렇게 라벨이 없는 대량의 데이터로 사전훈련을 하고, 라벨을 단 소수의 데이터로 다시 전이학습을 합니다. 그만큼 사람의 노력이 줄어든다는 장점이 있습니다.

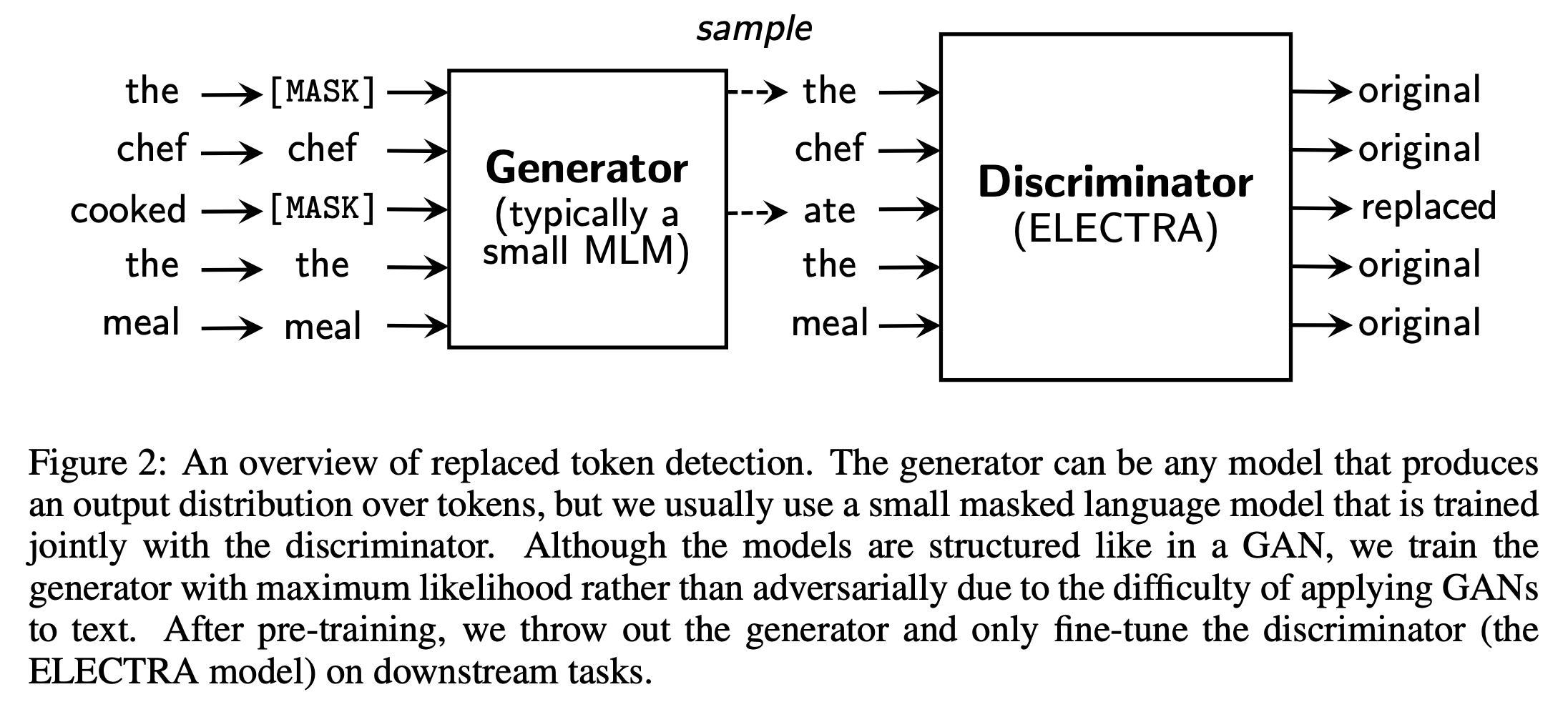

이미지와 자연어처리에서 자기지도 방법이 약간 비슷하게 흘러가는 것 같습니다. 처음에는 이미지를 격자로 조각내고 빈 칸의 영역을 맞추었습니다. BERT의 마스킹과 유사합니다. 요즘에는 SimCLR 같은 contrastive learning을 이미지 자기지도학습에 사용합니다. 원본 사진과 변형된 사진을 비교하는 방식입니다. ELECTRA 역시 이와 유사합니다. 문장에서 특정 단어들을 마스킹하여 새로 생성한 후에, 원본 단어인지 바뀐 단어인지 판단합니다.

새로운 기법들이 빠르게 나오고 있어 따라잡기가 벅차네요^^; 그래도 변화의 시대 한복판에 있다는 사실이 즐겁습니다.