- AI Dev - 인공지능 개발자 모임

- 정보공유

- 챗봇 딥러닝

https://tensorflowkorea.gitbooks.io/tensorflow-kr/content/g3doc/tutorials/seq2seq/

Seq2Seq는 RNN을 사용해서 문장을 학습할 수 있는 모델입니다. 여러가지 문서를 찾아봤는데 위의 링크가 그중에서 가장 잘 설명하고 있는 것 같습니다.

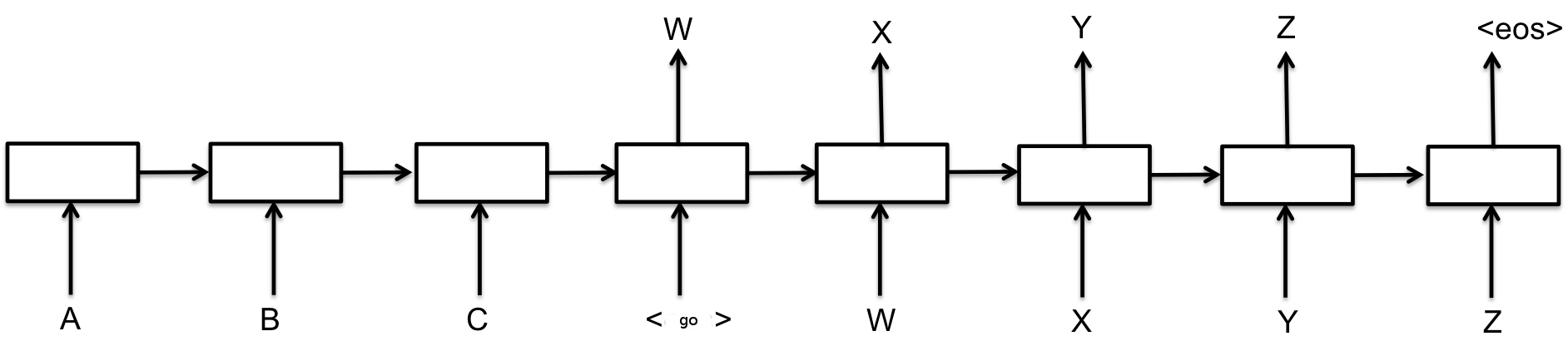

Seq2Seq는 2개의 RNN 셀로 구성됩니다. 위 그림에서 ABC를 입력으로 받는 것이 인코더 RNN 셀이고 오른쪽의 <go>WXYZ를 입력으로 받는 것이 디코더 RNN 셀입니다.

그림에서는 모두 8개의 셀이 있지만 실제로는 2개의 인코더와 디코더 셀만 존재합니다. RNN은 자신의 출력도 입력으로 받기 때문에 위 그림은 순차적인 입력을 풀어서 표현한 것입니다.

ABC라고 입력하면 WXYZ라고 대답하도록 훈련하고 싶다면 인코더에 ABC를 순서대로 집어넣습니다. 그리고 <go>WXYZ를 디코더에 순차적으로 입력하고 각각 출력이 WXYZ<eos>가 되도록 학습합니다.

정리하자면 ABC<go>WXYZ -> ___WXYZ<eos>으로 훈련을 시킨다고 보시면 됩니다. 여기서 <go>는 문장의 시작을, <eos>는 문장의 끝을 나타냅니다. 그리고 각 단어는 Word2Vec 같은 방법을 사용해서 벡터로 표현합니다.

이렇게 트레이닝이 된 모델을 사용해서 문장을 예측할 수 있습니다. ABC라고 인코더에 순차적으로 입력하고 디코더에 <go>를 넣은후 그 출력인 W를 다음번 입력으로 합니다.

이렇게 반복해서 디코더에 넣다가 <eos>가 나오면 종료합니다. 디코더의 출력을 합치면 WXYZ<eos>의 답변문장을 구할 수 있습니다.

보다 자세한 사항은 아래의 챗봇 구현 코드를 참고하시기 바랍니다.

딥러닝 RNN으로 구현한 챗봇

-> http://aidev.co.kr/chatbot/1852

< 챗봇 개발자 모임 >

- 페이스북 그룹에 가입하시면 챗봇에 대한 최신 정보를 쉽게 받으실 수 있습니다.