- AI Dev - 인공지능 개발자 모임

- 정보공유

- 챗봇 딥러닝

https://arxiv.org/abs/1811.01241

페이스북에서 발표한 논문인데 위키피디아의 정보를 사용하여 잡담을 할 수 있는 딥러닝 학습 모델입니다.

현재 나와있는 챗봇은 보통 위키의 내용을 먼저 지식그래프로 DB에 저장합니다. 그리고 질문이 들어오면 거기에 해당되는 정보를 찾아 템플릿 문장에 넣어 출력합니다.

지식그래프 : 아이유->키 = 160cm

질문 : 아이유 키가 얼마야?

의도 : 지식검색 / 개체 : 아이유, 키

템플릿 문장 : (인물)의 (특성)은/는 (수치)입니다.

대답 : 아이유의 키는 160cm입니다.

이런 방식의 문제점은 우선 위키의 내용을 분석하여 지식그래프로 변환하기가 어렵다는 것입니다. 그리고 의도를 판단한 후 대답 문장을 생성하는 것도 일일이 사람이 코딩을 해야합니다.

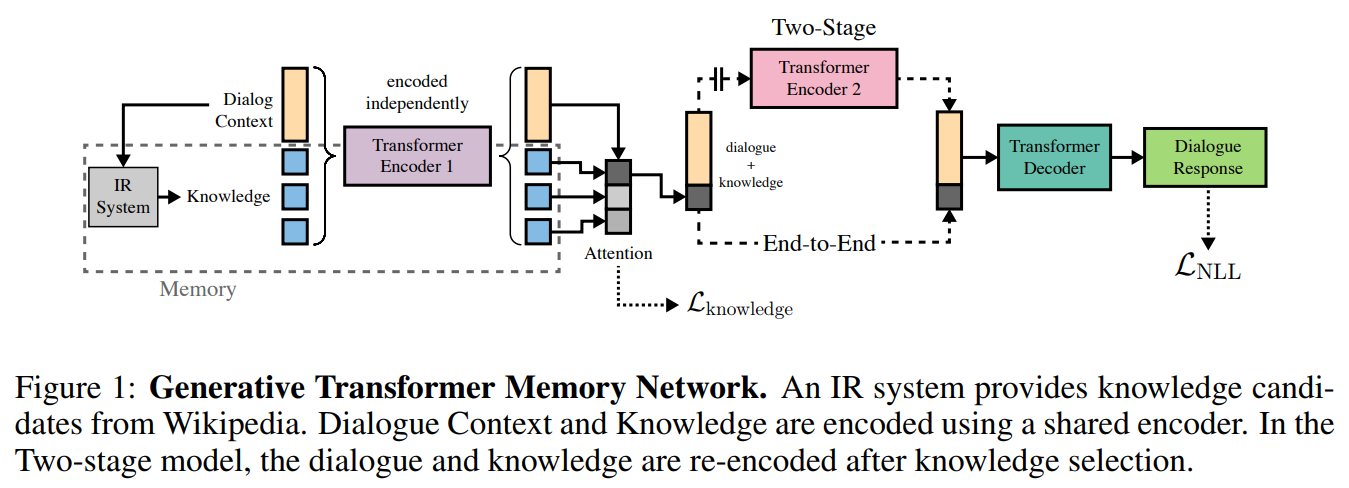

반면에 논문에서는 이러한 과정을 모두 학습으로 구현하였습니다. Memory Network와 Transformer를 합쳐서 Transformer Memory Network 모델이라고 부릅니다.

이전 대화 기록을 보고 IR(Information Retrieval)에서 관련된 위키페이지를 찾고 유사도가 높은 여러개의 문장들을 뽑아냅니다. 이 부분은 학습이 아니라 기존 검색 시스템을 사용합니다. 그리고 첫번째 스테이지에서 후보 문장 중 가장 관련이 높은 문장을 선택합니다. 그리고 두번째 스테이지에서 선택된 위키 문장을 사용하여 새로운 대답을 생성합니다.

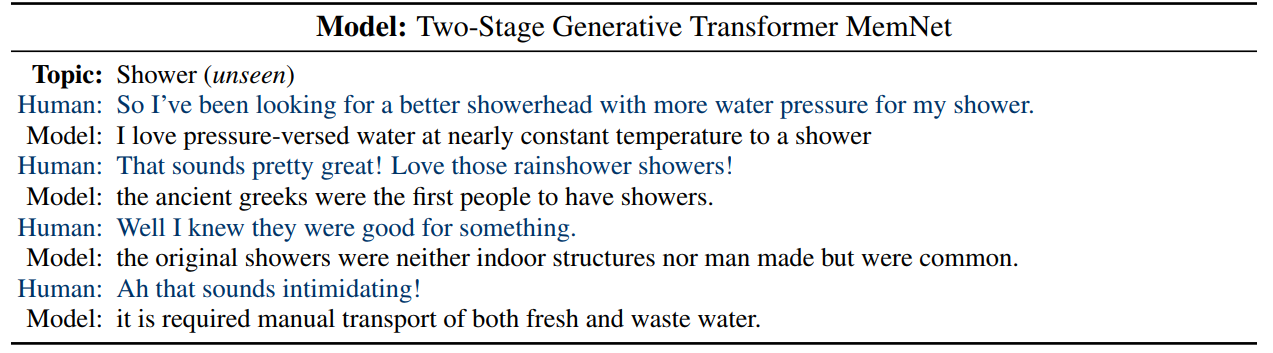

이 모델의 장점은 사람이 개입하지 않아도 질문에 대해서 위키정보를 검색하여 적절한 대답을 자동으로 만든다는 것입니다. 또한 딥러닝의 특징인 일반화로 인해 학습하지 않은 주제에 대해서도 스스로 위키의 정보를 이용해 대답을 할 수 있습니다. 다시 말하면 위키문장 자체를 학습하는 것이 아니라 위키의 문장을 찾아 가공하여 새로운 문장을 만드는 방법을 배우는 것입니다.

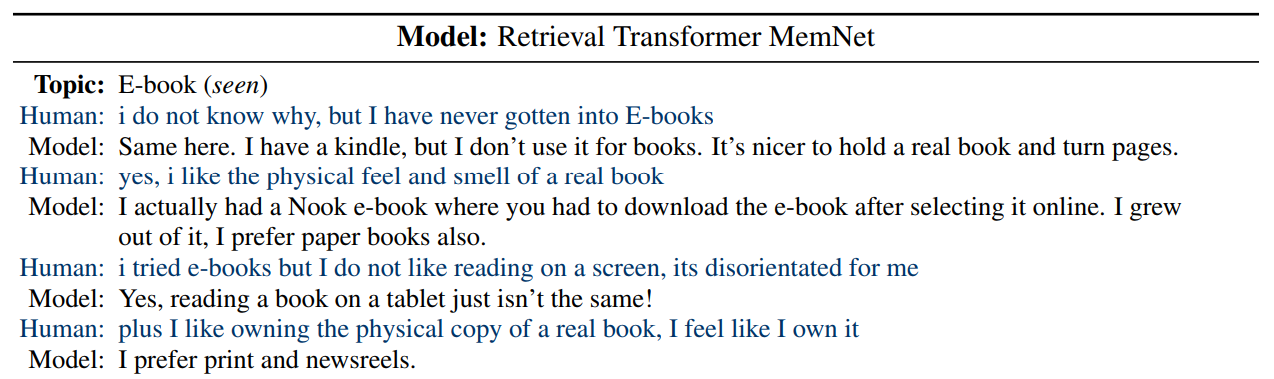

스크린샷을 보면 학습 데이터에 있는 E-book 주제만이 아니라 처음 접하는 Shower라는 카테고리에 대해서도 상당히 자연스럽게 문장을 만들어내고 있습니다.