WWDC 2024에서 Apple Intelligence가 공개됐습니다. 그중 시리의 변화가 가장 인상적이었습니다. 시리는 2011년 처음 출시되었지만 사용이 매우 저조한 편입니다. 룰베이스나 머신러닝 기반이라 말을 잘 못알아듣기 때문입니다. 알람이나 메모 등 간단하고 명확한 작업에만 그나마 쓸모가 있었습니다.

이제 시리에 LLM이 도입되면서 완전히 바뀌었습니다. 영화 Her의 사만다와 비교할 수는 없겠지만 상당히 유용해졌습니다. 가장 먼저 On-screen awareness 방식을 들 수 있습니다. 이전에는 시리가 별도의 화면으로 독립되어 있었습니다. 지금은 현재 화면에서 바로 시리가 동작합니다. 그래서 내가 하고 있는 일을 이해하고 거기에 맞게 대답이나 행동을 합니다.

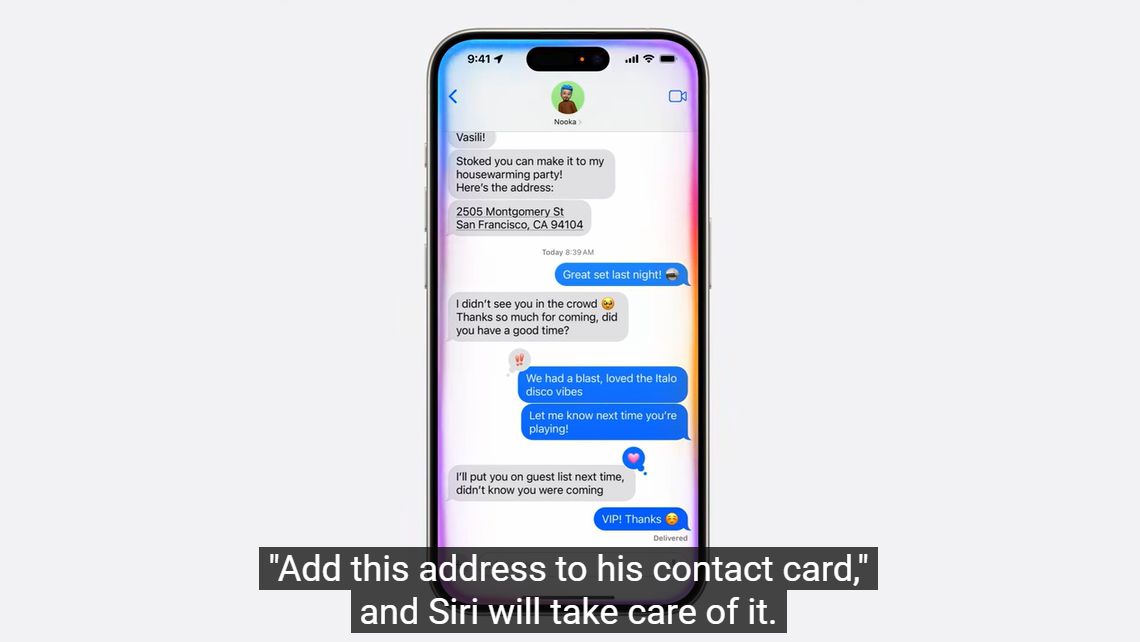

예를 들어 친구와 메시지를 주고 받다가 친구가 말한 주소를 연락처에 추가하려고 합니다. 말풍선을 눌러 주소를 복사하고 연락처를 실행합니다. 그리고 친구의 연락처를 검색해서 주소 항목에 붙여넣기를 해야 합니다. 이제 그냥 시리에게 말하면 한번에 이 과정이 완료됩니다. 시리가 내 명령뿐만 아니라 메시지 화면을 이해하고 있기 때문입니다.

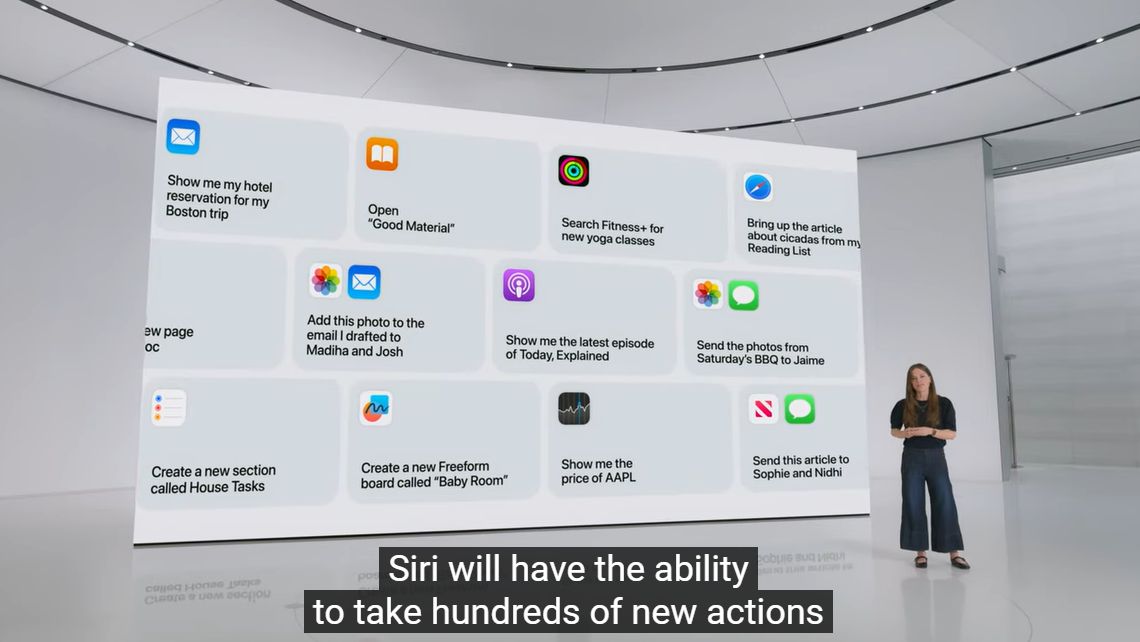

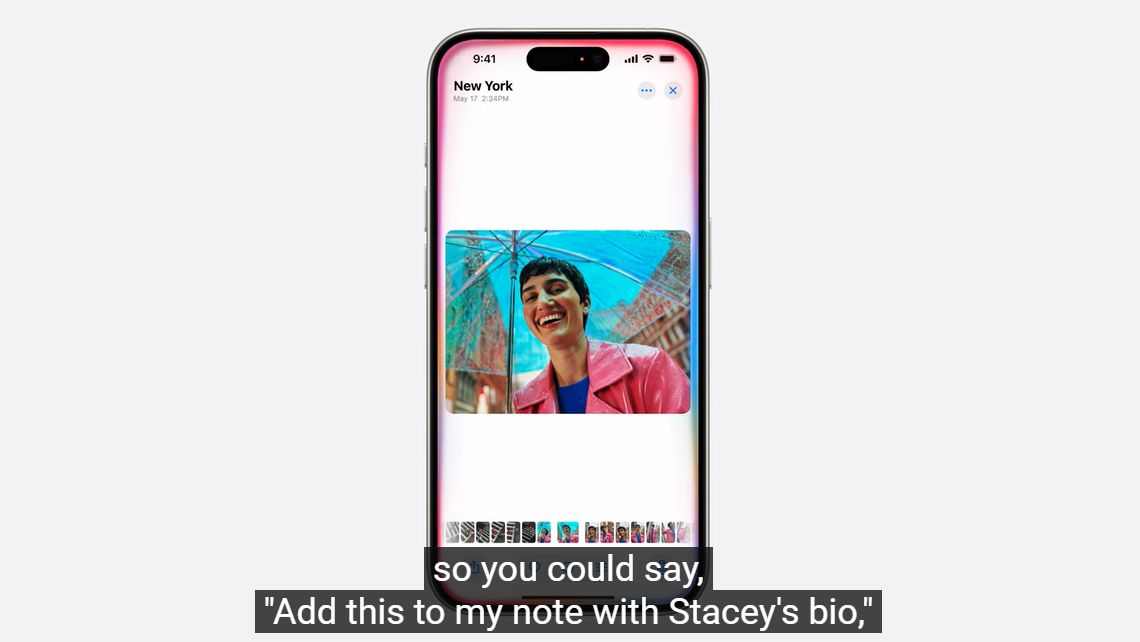

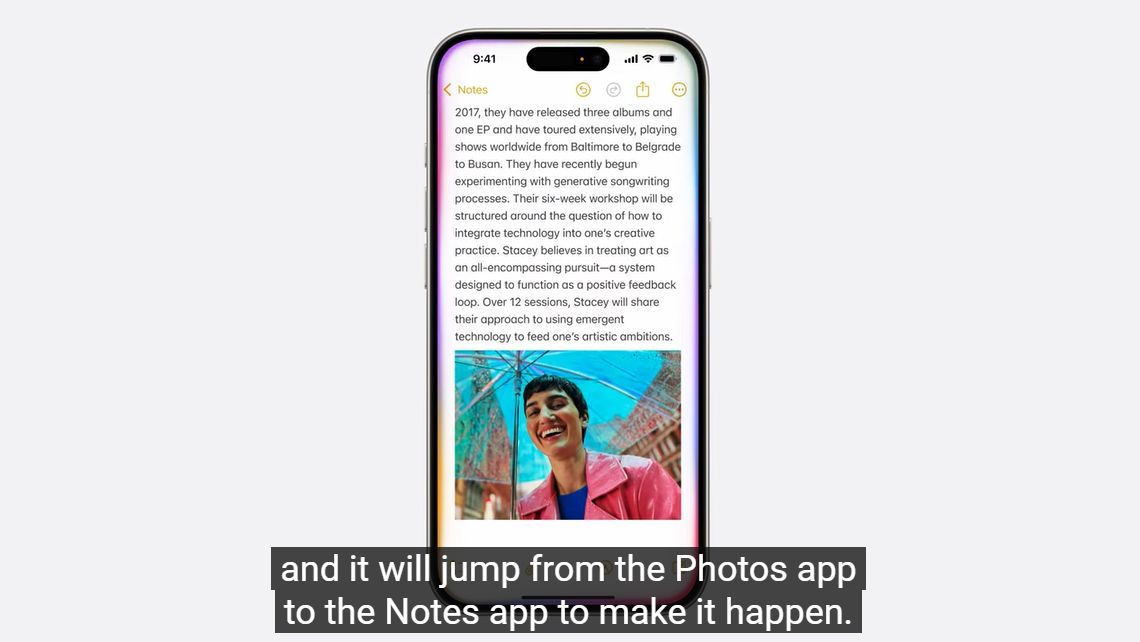

시리의 가장 강력한 기능은 In-app action입니다. 단순히 대답에서 끝나지 않고 실제 행동까지 이어집니다. 아이폰 내의 다양한 앱들과 연동할 수 있습니다.

사진을 말로 검색해고 그 사진을 노트에 붙여달라고 하는 등 모든 앱들을 시리를 통해 컨트롤 가능합니다.

이는 App Intents라는 방식으로 동작합니다. 각각의 행동을 구분하는 의도를 나타냅니다. 내장 앱 뿐만 아니라 자신의 앱에도 App Intents API를 통해 시리와 연동할 수 있습니다.

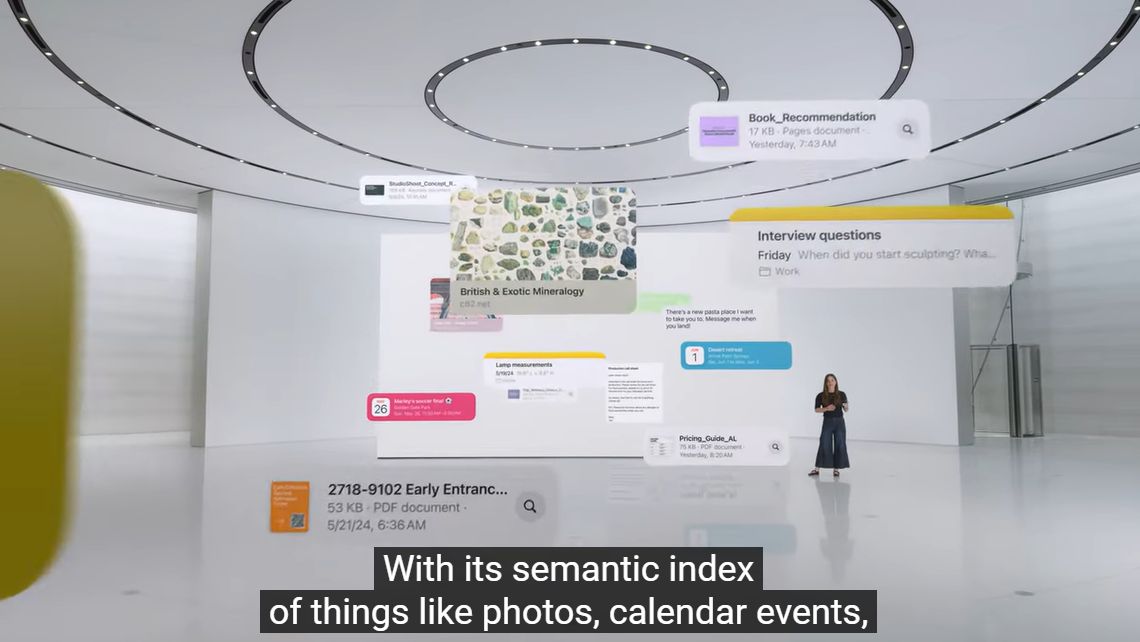

시리는 사용자의 Personal context에 접근하여 그 내용을 이해합니다. 사진, 캘린더, 메시지, 이메일 등 나의 모든 정보들을 포함합니다.

언제 어머니가 공항에 도착하냐고 물어보면, 이메일에서 나눈 기록을 참고하여 대답합니다. 점심에 뭘 먹기로 했냐는 질문에는 문자로 대화한 사실에 기반해서 알려줍니다. 덕분에 내가 메모장에 약속 내용을 일일이 정리할 필요가 없어졌습니다.

시리가 대답하기 어려운 질문은 OpenAI의 GPT-4o로 넘깁니다. 대신 그때마다 사용자에게 팝업으로 동의를 받습니다. 시리 내부에서는 보안이 철저합니다. 온디바이스에서 실행되거나 클라우드로 가더라도 애플에서 볼 수 없다고 합니다. 하지만 GPT-4o로 가는 개인정보는 위험할 수도 있어서 이런 절차가 추가된 것 같습니다.

확실히 이번 변화는 상당히 혁신적입니다. 새로운 것을 창조하기 보다는 기존 기술을 메인스트림으로 변화시키는게 애플의 장점이니까요. 사실 아직도 챗GPT를 한번도 안써본 사람들이 많은데요. 결국 AI의 대중화는 애플이나 구글 같은 플랫폼 회사들이 주도하지 않을까 합니다.

< 조코딩 소개 영상 >