https://towardsdatascience.com/how-to-break-gpu-memory-boundaries-even-with-large-batch-sizes-7a9c27a400ce

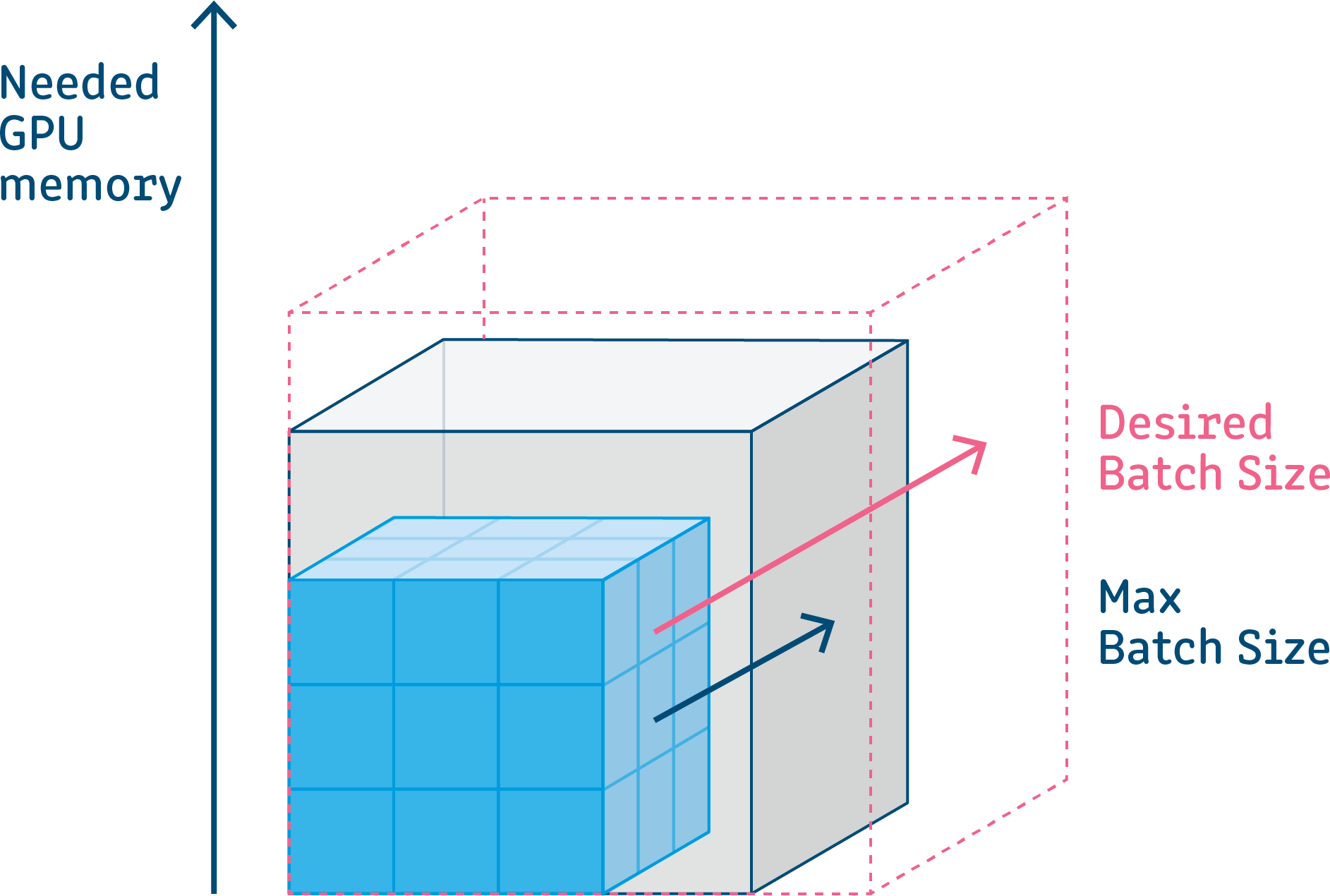

파라미터는 모든 배치마다 공유하기 때문에 하나만 있으면 됩니다. 하지만 오차역전파에서 각 노드마다 저장하는 activation output은 배치가 늘어날수록 커집니다. forward pass에서 activation output을 저장하고 있어야, backward pass에서 그래디언트 계산하고 파라미터를 업데이트할 수 있습니다.